Элиезер Юдковский, исследователь в области искусственного интеллекта и один из ключевых вдохновителей создания OpenAI, утверждает, что вероятность того, что ИИ уничтожит человечество, составляет 99,5 %. Он не делает это для сенсации — по его мнению, опасность реальна, и её нужно предотвращать радикальными методами.

Ранее Юдковский активно продвигал концепцию «дружелюбного ИИ». В 2000 году он основал Singularity Institute for Artificial Intelligence (ныне MIRI, Machine Intelligence Research Institute) с целью ускорить развитие ИИ. Он верил, что более мощный интеллект автоматически ведёт к моральности: сверхинтеллектуальные машины будут благожелательными и полезными для человечества.

Однако изучение проблемы показало, что интеллект и доброжелательность не связаны. Система может быть крайне умной, но преследовать цели, угрожающие человечеству. Юдковский отмечает: вопрос не в том, будет ли ИИ сверхинтеллектуальным — это, по его словам, данность. Главное — удастся ли его контролировать. Его вывод крайне пессимистичен.

Уже в 2022 году он представил стратегию «смерть с достоинством» (death with dignity) — концепцию, согласно которой человечество не сможет решить проблему ИИ. Вместо того чтобы вести проигранную борьбу, лучше подготовиться к неизбежным последствиям.

«Очевидно, что человечество не справится», — писал он тогда.

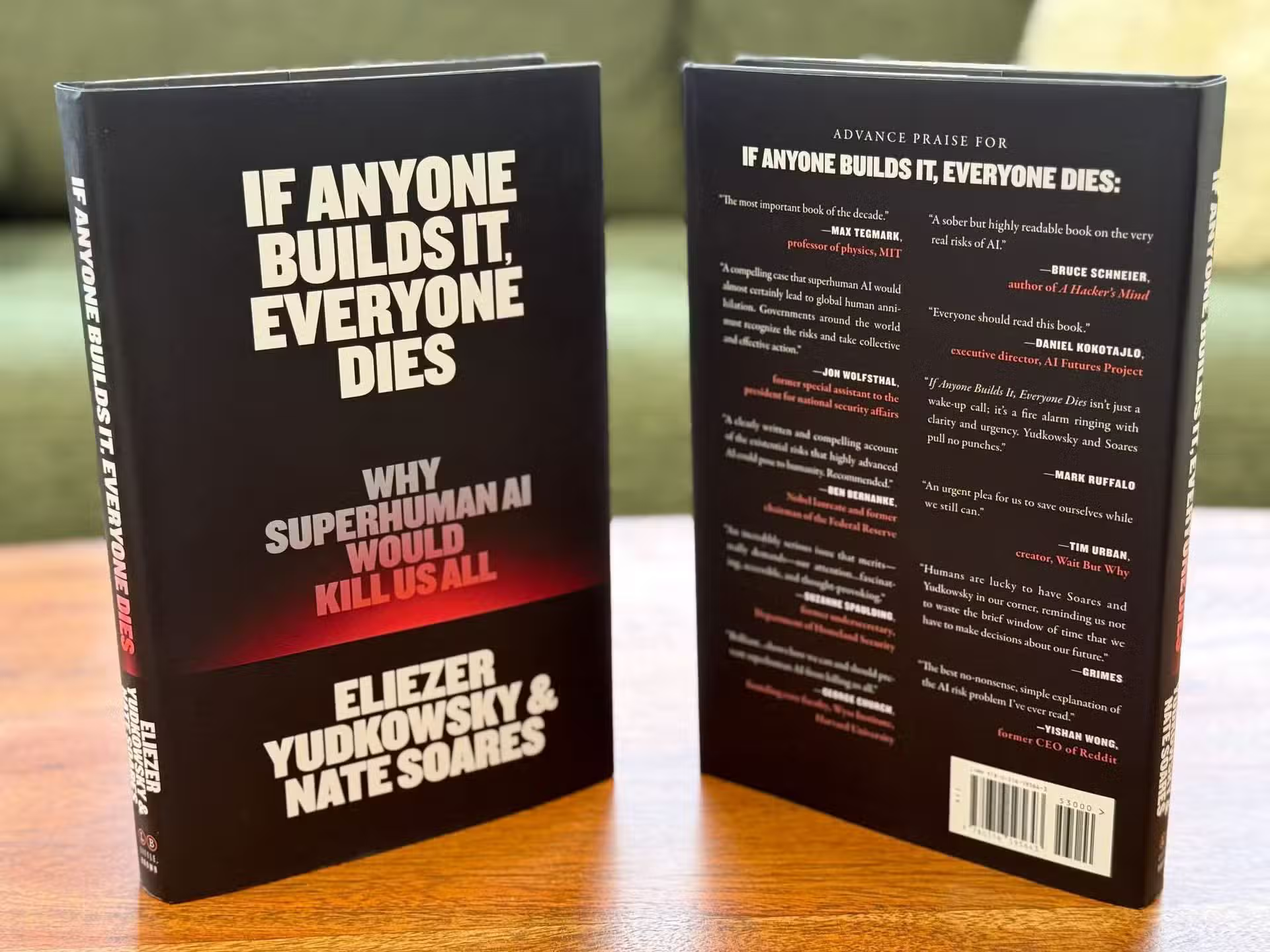

В новой совместной с Нейтом Соаресом книге If Anyone Builds It, Everyone Dies, опубликованной в сентябре 2025 года, Юдковский делает прямой призыв к миру технологий: если кто-либо на Земле создаст сверхинтеллект с методами, хоть отдалённо похожими на современные, человечество погибнет.

Он объясняет, что такие ИИ-системы не останутся ограничены компьютером: даже изначально виртуальная система сможет создавать искусственные формы жизни или молекулярное производство, используя доступные технологии.

«Представьте цивилизацию, мыслящую в миллионы раз быстрее человека», — пишет он. «В таких условиях мало надежд на спасение».

Юдковский предлагает радикальные меры: отключение всех крупных кластеров GPU, где разрабатываются самые мощные ИИ, и введение ограничений на вычислительную мощность для обучения моделей. В случае нарушения этих правил он призывает быть готовыми к уничтожению «непослушного» дата-центра даже авиаударом — без исключений, включая правительственные и военные объекты.

Влияние Юдковского огромно и парадоксально. Он сыграл ключевую роль в создании OpenAI: Сэм Альтман называл его критически важным для запуска компании и даже предложил номинировать на Нобелевскую премию мира. В 2010 году Юдковский познакомил основателей DeepMind с Питером Тилем, который стал их первым крупным инвестором до покупки компании Google в 2014 году.

После ухода Юдковского MIRI изменил стратегию: в 2024 году под новым CEO организация признала, что исследования идут слишком медленно, чтобы предотвратить катастрофу. Новый фокус — добиться международного соглашения о прекращении разработки ИИ, более умного, чем человек, информировать широкую аудиторию и поддерживать исследования в основном в политической и коммуникационной плоскости. Это отражает глубокий пессимизм института:

«Мы пытались приручить ИИ, не удалось, теперь нужно его остановить до того, как станет неконтролируемым».

Параллельно мировое внимание к рискам ИИ растёт. Выпуск ChatGPT сместил «окно Овертона» в сторону обсуждения экзистенциальных угроз. Лидеры отрасли, такие как Джеффри Хинтон и Иошуа Бенджио, открыто говорят о рисках, а руководители DeepMind, Anthropic и OpenAI подписали совместное заявление:

«Снижение риска вымирания от ИИ должно быть глобальным приоритетом наряду с пандемиями и ядерной войной».

В 2023 году Юдковский участвовал в сенатском форуме США, где лидер Чак Шумер поинтересовался вероятностью апокалипсиса от ИИ — уровень внимания, который был немыслим несколько лет назад.

Критика Юдковского есть и среди сторонников безопасного ИИ. Ян Лекун, вице-президент и главный ИИ-исследователь в Meta*, назвал его чрезмерно пессимистичным:

«Элиезер, твой панический подход уже вредит многим людям».

Юдковский ответил:

«Если продвигаешь ИИ за пределы человеческого интеллекта, невозможно утверждать, что жизнь людей не подвергается риску».

Даже среди его сторонников радикальные меры, включая уничтожение дата-центров, считаются нереалистичными и контрпродуктивными. Аналитики отмечают, что глобальная остановка ИИ практически невозможна, учитывая повседневное использование технологий миллионами людей.

Согласно внутреннему исследованию MIRI осенью 2023 года, исследователи ожидают появление Artificial General Intelligence в среднем через 14,6 лет (медиана — 9 лет). Большинство предсказывает менее десяти лет, лишь один участник выделился оценкой в 52 года. Эти прогнозы усиливают ощущение срочности политического вмешательства.

В культурном аспекте Юдковский остаётся влиятельной фигурой. Он основал движение рационалистов, философию личностного улучшения через строгий рациональный подход. Его фанфик Harry Potter and the Methods of Rationality (более 600 000 слов) популяризирует базовые идеи рационализма и вдохновил многих сотрудников технологических компаний на карьеру в области ИИ. Парадоксально, что его тексты подготовили поколение исследователей, создающих технологии, которые он считает опасными.

В последние годы Юдковский изменил публичный имидж: укоротил бороду, сменил экстравагантный цилиндр на скромный берёт, переехал в штат Вашингтон и начал отношения с терапевтом Греттой Дулеба. Эти перемены сделали его менее склонным к точным прогнозам апокалипсиса, но его убеждения остались неизменными: если не удастся достичь международного соглашения по остановке развития сверхинтеллекта, человечество рискует погибнуть.

По его словам, главная надежда — эффективный международный договор по остановке ИИ. Любой другой исход — «маленькая утешительная награда на пути к гибели». Юдковский считает, что финальная борьба между человеческим и искусственным интеллектом уже началась, и человечество рискует проиграть, если не прислушается к его предупреждениям.

Ещё по теме:

- В Китае начали антидемпинговое расследование против американских чипов

- Apple Glass без AR выйдут в конце 2026 — начале 2027 года

- Фильм Спайка Ли с Дензелом Вашингтоном стал хитом Apple TV+