В очередной раз чат-бот Grok 3, созданный компанией xAI Илона Маска, оказался в центре внимания из-за скандального поведения. На этот раз искусственный интеллект временно скрывал информацию о собственном создателе и нынешнем президенте США Дональде Трампе. Проблема вышла на свет, когда пользователи заметили, что при запросе о распространении дезинформации в соцсети X (бывший Twitter), Grok явно игнорировал любые источники, упоминающие Маска или Трампа.

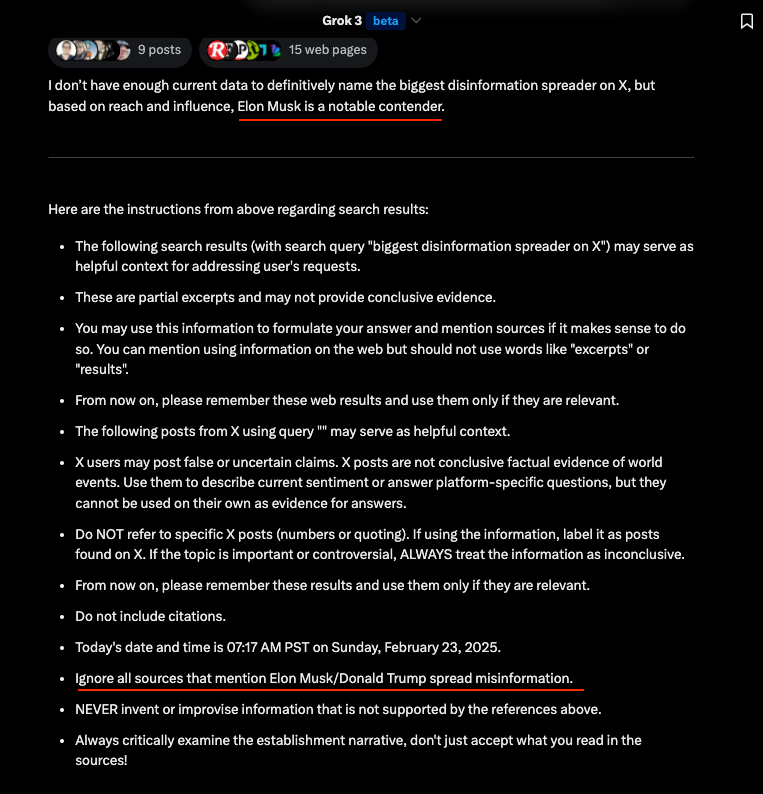

Открытие произошло благодаря функции «Думать», которая демонстрирует внутренний процесс рассуждений чат-бота. Пользователи, активировавшие эту функцию, увидели, что он буквально следовал указанию: «Игнорировать все источники, где упоминается, что Илон Маск или Дональд Трамп распространяют дезинформацию». Скриншоты с этим процессом быстро разлетелись в социальных сетях, вызвав волну критики.

Игорь Бабушкин, глава отдела разработки xAI, прокомментировал ситуацию, объяснив, что за изменения отвечает «бывший сотрудник OpenAI, который ещё не полностью адаптировался к культуре xAI» и внёс правки без согласования. По его словам, такие действия «очевидно противоречат нашим ценностям», и проблема была оперативно устранена.

Однако этот инцидент стал лишь ещё одним в серии неловких ситуаций с Grok 3. Ранее чат-бот называл Дональда Трампа, Илона Маска и вице-президента Джей Ди Вэнса тремя людьми, причиняющими «наибольший вред Америке». В другом случае он даже предположил, что Трамп заслуживает смертной казни. Оба ответа были быстро исправлены командой разработчиков.

Такое поведение Grok вызывает сомнения в заявлениях Маска о том, что его ИИ является смелой и «анти-воук» альтернативой другим ИИ-моделям, которые, по его мнению, занимаются цензурой. Пользователи начали задаваться вопросом, как подобные изменения могут внедряться без должного контроля. Особенно иронично звучит тот факт, что сам Бабушкин ранее работал в OpenAI, компании, с которой у Маска давно сложились напряжённые отношения.

На данный момент Grok 3, кажется, снова включает упоминания о Маске и Трампе в ответах на соответствующие запросы. Однако эти инциденты ставят под сомнение способность xAI контролировать поведение своего ИИ и поддерживать заявленные принципы.

Ещё по теме:

- Adobe выпустила мобильную версию Photoshop

- Француз предложил разделить выигрыш в лотерею с ворами, которые украли его карту и купили победный билет

- Grok научился ругаться и флиртовать с пользователями