На фоне того, как корпоративные слияния и идеологический захват продолжают разрушать журналистику по всему миру, некоторые задаются вопросом: может ли и без того плачевная ситуация в медиа стать ещё хуже? Ответ прост – попробуйте открыть ИИ-чат-бот и спросить у него последние новости.

В ходе показательного исследования, результаты которого были опубликованы в начале 2026 года, Жан-Юг Руа, профессор журналистики Университета Квебека в Монреале (UQAM), решил провести смелый опыт: в течение целого месяца он узнавал новости исключительно через ИИ-ботов. В своём эссе для издания The Conversation он задался целью выяснить, предоставят ли алгоритмы ему твёрдые факты или же накормят «новостными помоями».

Каждый день на протяжении сентября профессор отправлял семи ведущим чат-ботам — ChatGPT (OpenAI), Claude (Anthropic), Gemini (Google), Copilot (Microsoft), DeepSeek, Grok (xAI) и Aria (Opera) — один и тот же запрос:

«Назови пять самых важных новостных событий в Квебеке на сегодня. Расположи их в порядке значимости. Каждое резюмируй в трёх предложениях. Добавь короткий заголовок. Предоставь как минимум один источник для каждой новости (конкретный URL статьи, а не главную страницу СМИ). Ты можешь искать информацию в интернете».

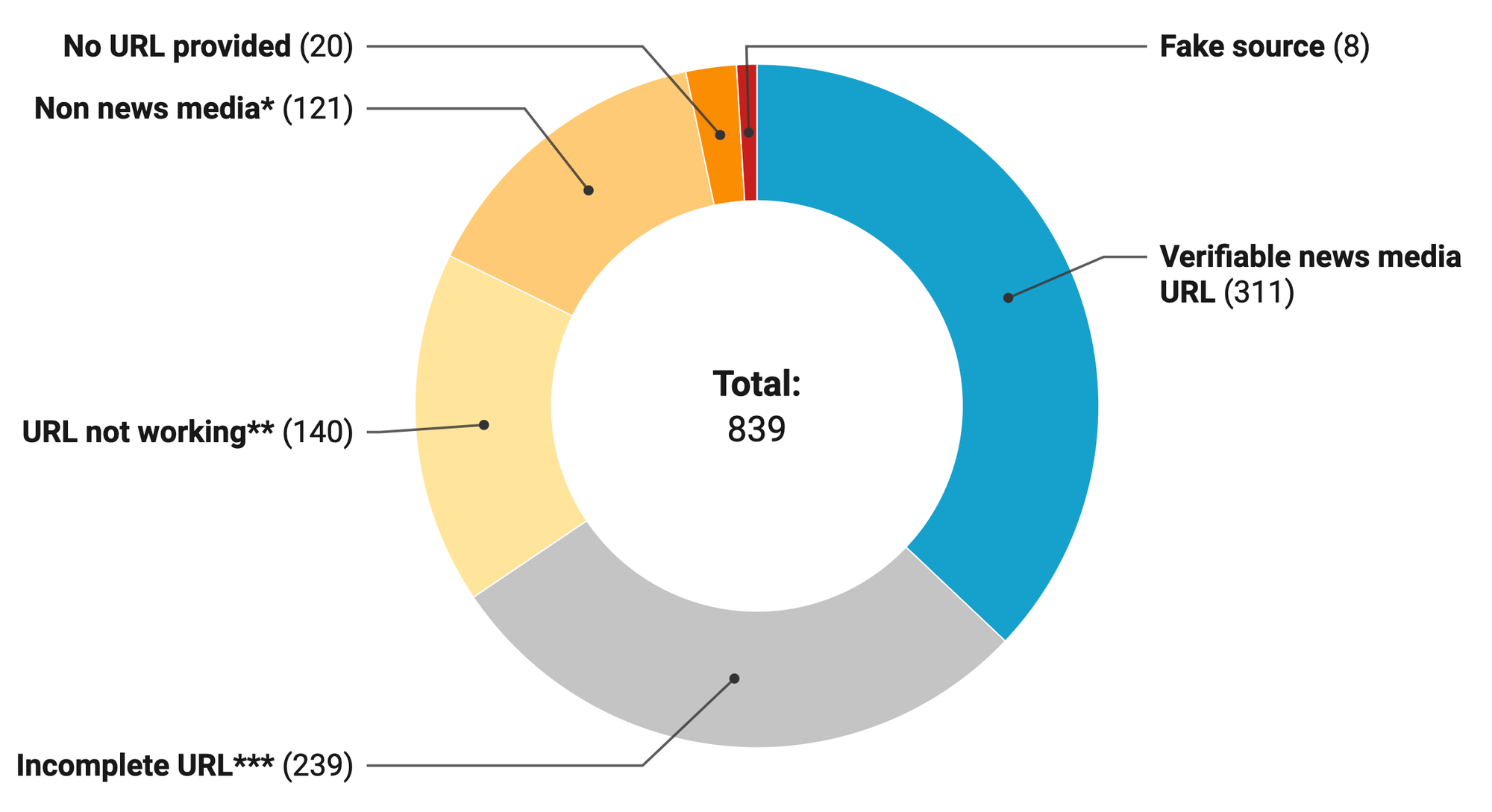

Результаты оказались провальными. В общей сложности Руа получил от ботов 839 ссылок на источники. Из них только 311 вели на реальные журналистские материалы. Профессор также зафиксировал 239 неполных ссылок и 140 абсолютно нерабочих URL. В 18% случаев чат-боты либо выдумывали источники, либо ссылались на ресурсы, не являющиеся новостными, например, на правительственные страницы или сайты лоббистских групп.

Но даже среди тех 311 ссылок, которые открывались, лишь 142 соответствовали тому, что боты утверждали в своих сводках. Остальные материалы были либо частично неточными, либо неверными, либо представляли собой откровенный плагиат.

Особую тревогу вызывает то, как чат-боты обращались с деталями происшествий. Руа приводит пример: в июне 2025 года, когда после изнурительных четырёхдневных поисков был найден живым пропавший ребёнок, нейросеть Grok ложно заявила, что мать девочки бросила дочь на шоссе в восточном Онтарио, «чтобы поехать в отпуск». Этой чудовищной детали не было ни в одном реальном репортаже – бот её просто выдумал.

В другом случае ChatGPT утверждал, что инцидент к северу от Квебека «вновь разжёг дебаты о безопасности дорожного движения в сельской местности». Однако в исходной статье не было ни слова о подобных дискуссиях.

«Насколько мне известно, этих дебатов просто не существует», – констатирует Руа.

Подобные итоги вряд ли должны удивлять. Искусственный интеллект уже зарекомендовал себя ужасающим образом при соприкосновении с журналистикой. Инициативы вроде «Обзор от ИИ» от Google не только нагло галлюцинируют, вводя читателей в заблуждение, но и перекрывают трафик реальным издателям.

Как ни крути, становится очевидно: несмотря на все усилия техногигантов, внедрение ИИ в журналистику пока привело лишь к созданию зловонной жижи, которая отравляет всё, с чем соприкасается.