Исследователи из университетов Бергена, Торонто и Гарварда обратили внимание на рост использования моделей генеративного ИИ в научной визуализации и на последствия, к которым это может привести.

В докладе, представленном на конференции IEEE VIS 2025, отмечено, что при развитии ИИ-инструментов вроде GPT-4o и DALL-E 3 до сих пор не сформированы стандарты биомедицинских изображений. Это формирует угрозу искажения информации и подрыва доверия к научным материалам.

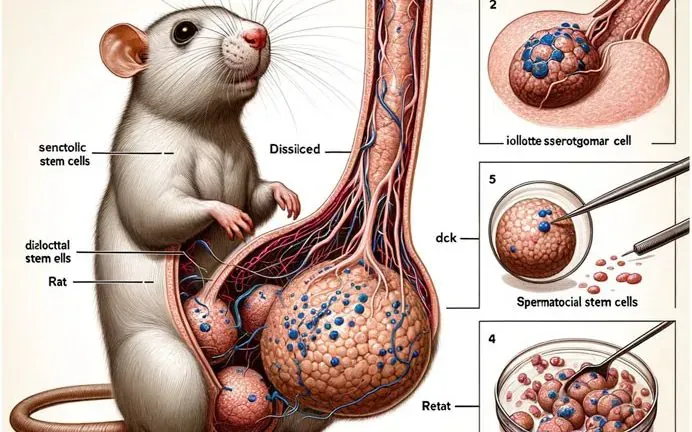

В исследовании представлены конкретные примеры изображений, полученных с помощью ИИ, и показано, как они отличаются от профессиональных научных иллюстраций. Некоторые ошибки носят поверхностный характер, другие же (к примеру, изображение крысы с гипертрофированными анатомическими элементами) ставят под сомнение научную состоятельность публикаций.

Главная проблема, по словам авторов — правдоподобие изображений. Фотореалистичность маскирует грубые неточности, что важно при визуализации медицинских процессов и органов. Сейчас, когда ИИ-модели для генерации картинок активно развиваются, подобная практика ощущается острее, поскольку ИИ-инструменты стали выдавать убедительные, но потенциально ложные материалы.

Один из авторов статьи, Роксанн Зиман, указывает, что в клинической медицине случаи прямого ущерба пока не зафиксированы, но параллели с другими сферами, например, ошибочной ИИ-оценкой социального поведения в Нидерландах, показывают, насколько опасны подобные просчёты. По её словам, научно-популярные ресурсы и СМИ могут усилить распространение некорректной визуальной информации, провоцируя ложные интерпретации даже среди специалистов.

В рамках исследования было проведено интервью с 17 экспертами по визуализации. На основе ответов выделено пять позиций — от полного принятия ИИ до категорического неприятия. Скептики указывали на повторяемость художественных решений и ограниченность выразительности. Например, модель MidJourney, по запросу «поджелудочная железа», демонстрировала не орган, а «яйца инопланетян».

Авторы зафиксировали и другую тревожную тенденцию — даже те, кто уже интегрировал ИИ в свою работу, называют приоритетом медицинскую точность, параметр, с которым современные модели не справляются. Пользователи также отмечали наличие вымышленных терминов, несуществующих объектов и случайных искажений, которые пока невозможно контролировать.

Одной из центральных тем статьи стала ответственность. Кто должен отвечать за результат — разработчик модели, её пользователь или научное издание? Один из опрошенных выразил мнение, что любая визуализация требует объяснения, т. к. без этого невозможно обеспечить доверие к источнику и профессиональную достоверность.

Ещё по теме:

- Глава OpenAI предупредил: переписки с ChatGPT не защищены законом

- Apple сохраняет стабильность и не спешит с ИИ: отчёт за третий квартал ожидается уверенный, но скромный

- Американские учёные обнаружили инопланетный корабль и предупредили о возможной атаке в ноябре