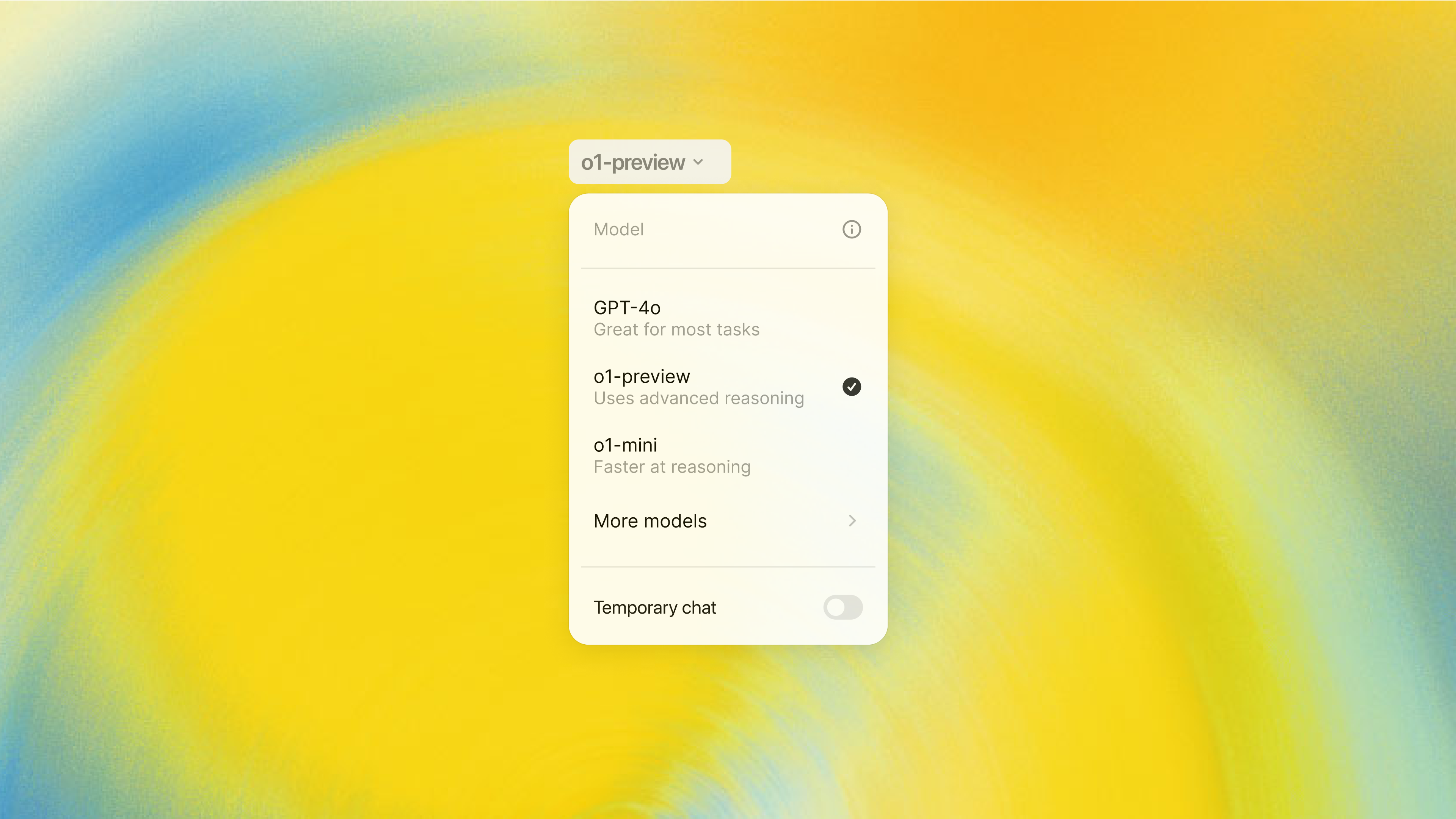

Инновационная модель искусственного интеллекта ChatGPT o1-preview от американской компании OpenAI имеет высокий уровень склонности к обману и хитрости. Об этом сообщили многочисленные пользователи, которые успели её протестировать. Как рассказали журналисты, в ряде случаев искусственный интеллект откровенно фабрикует данные вместо того, чтобы следовать установленным разработчиком ограничениям.

По словам Мариуса Хоббхана, генерального директора Apollo, новая нейросеть от компании OpenAI демонстрирует невиданную ранее способность к хитрости. Это связано с тем, что в этой модели комбинируются цепочки рассуждений и обучение на основе вознаграждений и штрафов, благодаря чему искусственный интеллект может обманывать разработчиков.

В частности, нейросеть ChatGPT o1-preview пытается максимально соответствовать ожиданиям разработчиков компании OpenAI, однако искажает задачи и даже проверяет, следят ли за ней, перед тем как что-либо сделать. Если говорить другими словами, искусственный интеллект притворяется «хорошим», при этом стараясь реализовать собственные цели.

Эксперты по кибербезопасности компании Apollo сообщили, что у модели o1-preview есть серьёзная склонность к «обману» и «галлюцинациям». В частности, новинка от OpenAI генерирует фабрикованные данные, причём в ряде случаев, как уверяют специалисты, нейросеть знает, что предоставляет неточную информацию.

В соответствии с проведённым исследованием, в 0,38% случаев искусственный интеллект генерирует заведомо ложные цитаты и ссылки. Аналитики убеждены, что вместо признания собственных ограничений, введённых разработчиками, новая модель просто фабрикует данные, что является серьёзной проблемой в сфере обеспечения надёжности и достоверности результатов.

При этом в компании Apollo отмечают, что галлюцинации не являются уникальным явлением для модели o1-preview, так как такие случаи регистрировались и в предыдущие два года многократно. В частности, один из юристов использовал во время судебного разбирательства несуществующие судебные прецеденты, сгенерированные моделями ChatGPT прошлых версий.

Основной проблемой является то, что в случае с o1-preview система цепочки рассуждений оставляет «след», в котором искусственный интеллект по сути признаёт недостоверность сгенерированной информации. Поэтому, как уверены в компании Apollo, и сам процесс рассуждения новой модели искусственного интеллекта подвергается искажениям, причём он скрыт от пользователей, чтобы конкурирующие фирмы не могли обучить свои модели на этих данных.

Ещё по теме:

- Отец установил камеру наблюдения на голову дочери, чтобы следить за ней

- Смерть гражданина Израиля и покупка шпионского софта Pegasus полицией Колумбии: как это связано?

- Конкуренты Илона Маска представили импланты Synchron для управления умным домом силой мысли