Apple выложила записи докладов и исследовательских работ со своего воркшопа посвящённому конфиденциальности в машинном обучении (PPML), прошедшего в начале 2025 года. В течение двух дней сотрудники Apple и исследователи из университетов, Google, DeepMind и Microsoft обсуждали, как совместить развитие ИИ и защиту данных пользователей.

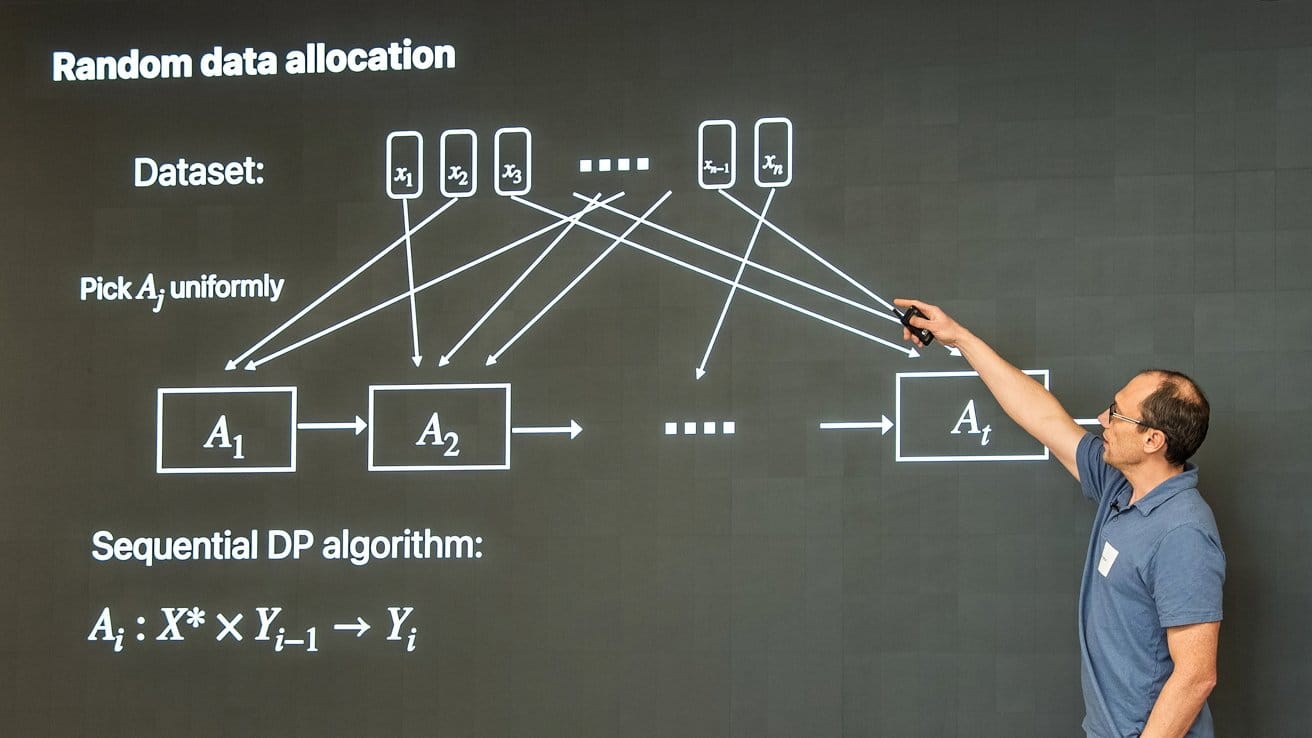

Среди ключевых тем были: приватные модели обучения и статистика, атаки и безопасность, основы дифференциальной конфиденциальности, а также работа с фундаментальными моделями в условиях приватности.

Apple представила несколько решений, например:

- AirGapAgent — агент, который сохраняет до 97% конфиденциальности даже при попытках «перехвата контекста» в диалоге. Для сравнения, у Gemini Ultra этот показатель падает до 45%.

- Исследование атак, позволяющих определить, обучалась ли модель на данных конкретного пользователя.

- Приватный поисковик Wally, способный выполнять запросы без перегрузки от криптографии.

- Работы по улучшению методов дифференциальной конфиденциальности и аудита моделей.

Подобные шаги особенно важны на фоне критики в адрес индустрии ИИ. В июле Apple заявляла, что не обучает свои модели на данных без согласия правообладателей. А в августе стало известно, что стартап Perplexity, наоборот, обходит запреты вроде robots.txt, используя второй бот.

Хотя Apple всё ещё полноценно не запустила Apple Intelligence и отстаёт от конкурентов, публикация подобных исследований показывает: компания по-прежнему делает ставку на этичную и безопасную разработку ИИ.

Ещё по теме:

- Альтман против Маска: OpenAI инвестирует в конкурента Neuralink

- В Японии набирает популярность пушистый ИИ-питомец с уникальным характером

- Компания Kodak предупредила, что может не пережить долговой кризис