Развитие искусственного интеллекта упёрлось в заметный предел, по крайней мере в сфере сложных академических знаний. Это показал бенчмарк Humanity’s Last Exam, в котором даже самые продвинутые модели рынка не смогли приблизиться к уровню эксперта человека и остались ниже отметки 40% правильных ответов.

Экзамен построен как жёсткая проверка глубины мышления. В нём 2 500 заданий из более чем 100 научных областей. Диапазон тем намеренно сделан максимально широким и нестандартным. В одном вопросе требуется разбираться в древних пальмирских надписях, в другом анализировать строение скелета колибри или выводить нетривиальные математические зависимости.

Лучший результат на текущий момент показала модель Gemini 3 Pro Preview с точностью 37,52%. Далее идут GPT-5 с показателем 31,64% и Claude Opus 4.5, набравшая 25,2%. Даже лидер остаётся заметно ниже уровня эксперта человека, который в рамках этого экзамена оценивается примерно в 90%.

Китайские системы в этом тесте выступили слабее. Модель glm-4p5 от Zhipu AI смогла набрать лишь 8,32%, а остальные разработки, в том числе Alibaba Qwen3 и DeepSeek, показали ещё более скромные результаты. Разрыв между лидерами и остальными участниками измеряется десятками процентных пунктов.

Контраст заметен на фоне других популярных бенчмарков. В тестах уровня MMLU современные ИИ давно чувствуют себя уверенно и часто показывают точность выше 90%. Именно поэтому Humanity’s Last Exam задумывался как альтернатива привычным проверкам. Его цель состоит не в оценке общей эрудиции, а в выявлении способности рассуждать, анализировать и работать с редкими, плохо структурированными знаниями. Описание проекта было опубликовано в журнале Nature в январе 2026 года, а сам экзамен впервые представили в начале 2025 года некоммерческая организация Center for AI Safety и компания Scale AI.

Над созданием HLE работали около 1 000 экспертов из более чем 500 организаций в 50 странах. Чтобы мотивировать авторов придумывать действительно сложные задания, был сформирован призовой фонд в размере 500 000 долларов. По 5 000 долларов получили создатели 50 лучших вопросов, ещё 500 участников получили по 500 долларов. Из огромного массива предложений строгий отбор прошли лишь 2 500 заданий, которые и вошли в открытую версию экзамена. Дополнительно существует закрытый резерв вопросов, предназначенный для проверки того, не заучивают ли модели уже опубликованные ответы.

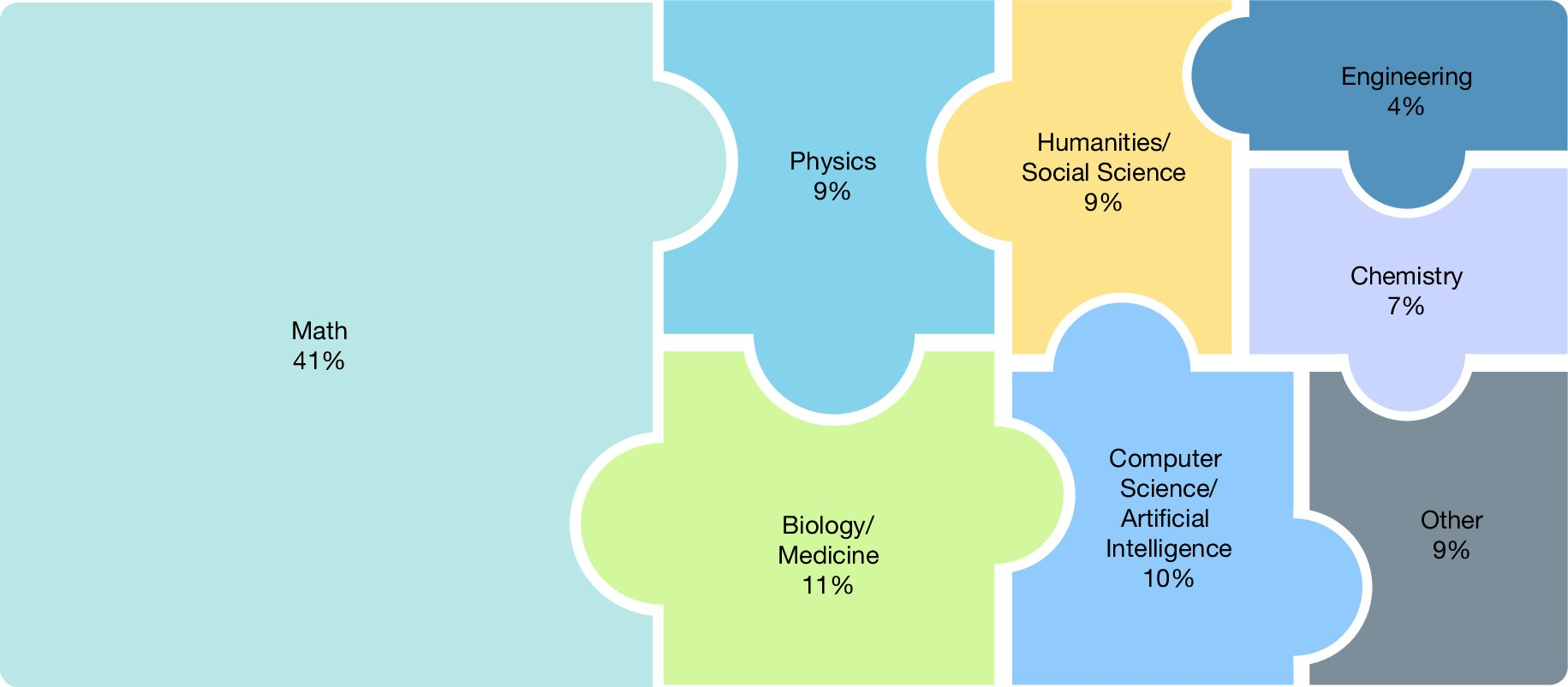

Структура экзамена тоже далека от простой. Около 14% заданий относятся к мультимодальным и требуют одновременной работы с текстом и изображениями. Примерно 24% представляют собой вопросы с выбором ответа. Остальная часть — это короткие ответы, проверяемые автоматически. Математика занимает 41% всего набора, оставшиеся задания распределены между физикой, биологией, информатикой и гуманитарными дисциплинами. Каждый вопрос сопровождается развёрнутым обоснованием решения, что повышает проверяемость и уровень сложности.

На старте проекта в январе 2025 года результаты выглядели ещё более жёстко. GPT-4o тогда показала лишь 2,7%, Claude 3.5 Sonnet набрала 4,1%, а o1 остановилась на уровне 8%. С тех пор показатели выросли, но ни одна модель так и не приблизилась даже к половине экспертного уровня. Лидером остаётся Gemini 3 Pro Preview, за ней следуют GPT-5 и Claude Opus 4.5 с заметным отставанием.

Отдельного внимания заслуживает вопрос уверенности моделей. Создатели экзамена обращают внимание, что важно смотреть не только на процент верных ответов, но и на то, насколько ИИ адекватно оценивает собственные знания. В публикации в Nature говорится, что многие системы дают неверные ответы с высокой степенью самоуверенности. Для этого в тест добавили метрику ошибки калибровки RMS, которая показывает расхождение между заявленной уверенностью и реальной точностью. Чем ниже показатель, тем лучше. У Gemini 3 Pro Preview он равен 57, у последней версии GPT-5 — 49, тогда как у большинства моделей значение превышает 70. Это означает, что даже сильные системы нередко звучат убедительно, но ошибаются.