Последние годы показали, как поиск в интернете изменился с появлением искусственного интеллекта. Если традиционные поисковые системы выдают упорядоченный список ссылок, то системы на базе больших языковых моделей работают иначе — они синтезируют информацию из множества источников и выдают единый связный ответ. Однако, оказывается, этот новый подход приводит к совершенно неожиданным результатам.

Исследователи из Рурского университета в Бохуме и Института систем Общества Макса Планка провели масштабное исследование, под названием «Characterizing Web Search in The Age of Generative AI». Его авторы сравнили традиционный поиск Google с четырьмя системами поиска на базе искусственного интеллекта: Google AI Overview, Gemini-2.5-Flash, GPT-4o-Search и GPT-4o с поисковым инструментом. Для анализа они использовали более четырёх тысяч запросов из различных источников — от социальных сетей до данных о самых популярных товарах на Amazon.

Результаты исследования оказались удивительными. Обнаружилось, что поисковые системы на базе искусственного интеллекта активно обращаются к неизвестным сайтам, которые вообще не попадают в топ результатов традиционного поиска. Возьмём, например, Google AI Overview («Обзор от ИИ») — в 53% случаев он использует источники, которые не появляются в первой десятке результатов обычного поиска Google. Более того, целых 40% этих источников не входят даже в топ-100. Что касается Gemini, то эта система показала наиболее ярко выраженную тенденцию к использованию малопопулярных доменов — в её результатах медианное значение ранга источников падает за пределы топ-1000 сайтов по популярности.

Для измерения популярности сайтов исследователи использовали сервис Tranco, который отслеживает один миллион наиболее посещаемых доменов. Результаты показали, что традиционная поисковая система Google цитирует сайты, входящие в топ-1 миллион на 89%. Для AI Overview этот показатель составляет 85%, для GPT-4o с инструментом поиска — 81%. Интересно, что разные системы искусственного интеллекта используют совершенно разное количество источников. Если GPT-4o с инструментом поиска полагается всего на 0,4 веб-страницы в среднем, то AI Overview использует 8,6, Gemini — 8,5, а GPT-4o-Search — 4,1.

Исследование также раскрыло фундаментальные различия в том, как генеративные системы поиска используют внутренние знания, заложенные в параметры модели, и на информацию, полученную из интернета. Некоторые системы активнее используют внутренние знания и реже ищут в сети, в то время как другие постоянно обращаются к внешним источникам. Это означает, что разные системы будут давать разные ответы на одни и те же вопросы.

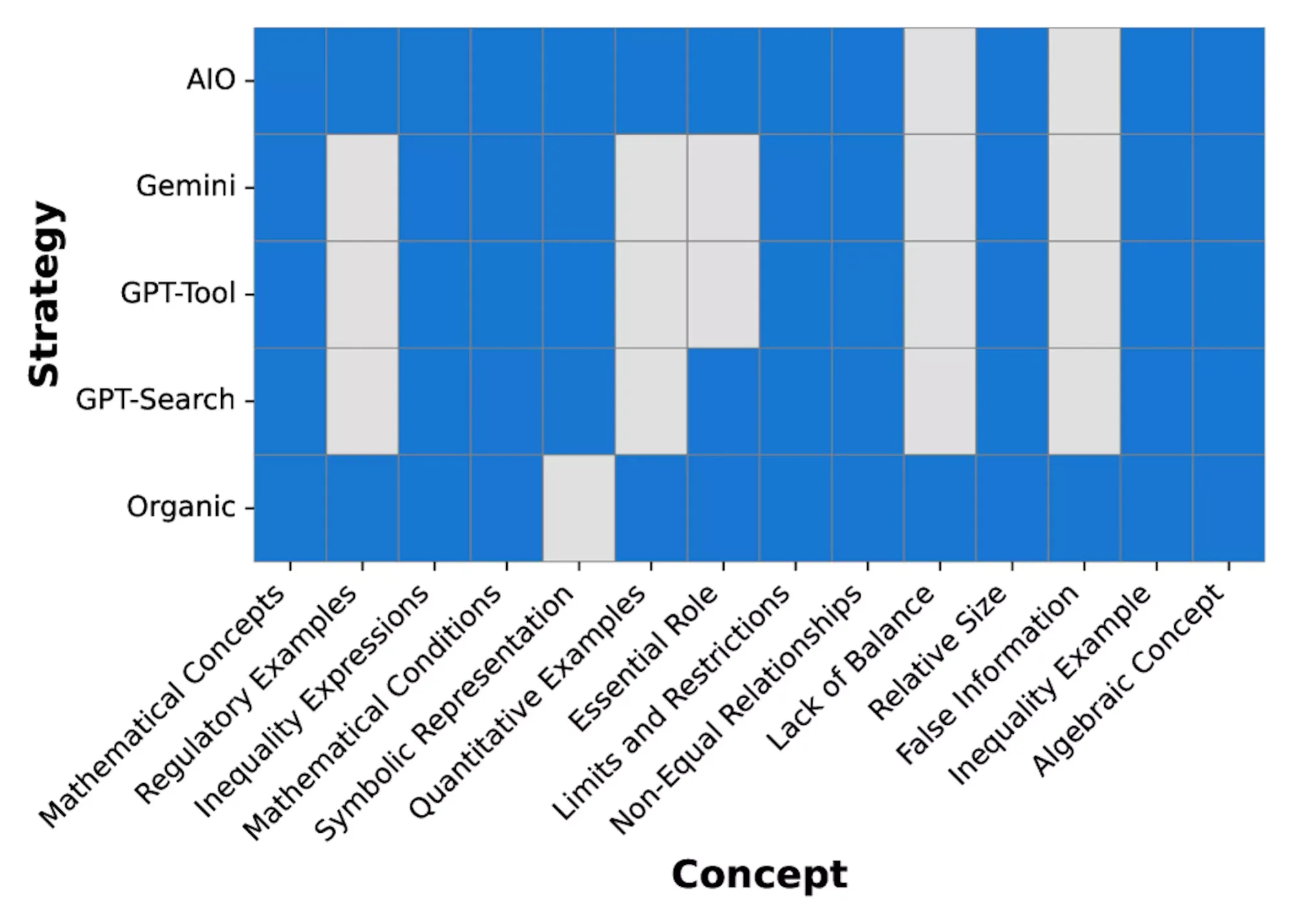

Анализ содержания показал, что несмотря на использование более широкого спектра источников, ИИ-системы покрывают примерно такое же количество тематических концепций, что и традиционный поиск. Однако здесь кроется важный нюанс — каждая система подаёт разные информационные аспекты. Некоторые концепции, которые охватывает традиционный поиск, могут быть упущены генеративными системами, особенно когда речь идёт о неоднозначных запросах или вопросах, требующих рассмотрения множества разных точек зрения.

Когда дело касается современных событий и актуальной информации, различия становятся ещё более заметными. Системы, которые активно извлекают много источников (GPT-4o-Search и Gemini) справляются с трендовыми запросами лучше. В то же время модели, которые сильно полагаются на встроенное знание, испытывают трудности с информацией о свежих событиях.

Важным выводом из исследования стало то, что существующие методы оценки качества поиска, разработанные для традиционных упорядоченных списков результатов, уже не подходят для оценки генеративного поиска. Исследователи подчёркивают необходимость разработки новых подходов к оценке, которые бы учитывали разнообразие источников, полноту тематического охвата и особенности синтеза информации.

Этот сдвиг в способах поиска информации имеет значительные последствия для всех пользователей. Интернет становится более фрагментированным, с разными системами приводящими людей на разные сайты. Неизвестные источники получают больше внимания, но при этом возникают новые вопросы о надёжности и релевантности информации, которую люди находят через системы искусственного интеллекта. В то же время это открывает новые возможности для расширения разнообразия источников и предотвращения чрезмерного сосредоточения трафика на крупнейших сайтах.

Исследователи выявили, что различия в выборе источников и использовании внутреннего знания могут незаметно изменять, какие точки зрения и факты видят пользователи, даже если общий охват тематики остаётся схожим. Сокращённый формат ответов генеративного поиска изменяет способ упаковки и приоритизации информации, что может повлиять на прозрачность, доверие и активность пользователя при взаимодействии с результатами.

Результаты этого исследования подчёркивают возникающую в области информационного поиска необходимость переосмыслить подходы к разработке и оценке поисковых систем в эру искусственного интеллекта. Система оценивания должна одновременно учитывать всеобъемлющость информации, её краткость и фактическую обоснованность результатов. Такой комплексный подход сможет помочь разработчикам найти правильный баланс между предоставлением полезной информации и сохранением разнообразия источников в сети.

Ещё по теме:

- Павел Дуров представил децентрализованную сеть для конфиденциальных ИИ-вычислений Cocoon

- Apple потратила $8 млн на лоббирование в ЕС и провела 76 встреч

- NVIDIA стала первой компанией в мире с капитализацией $5 трлн