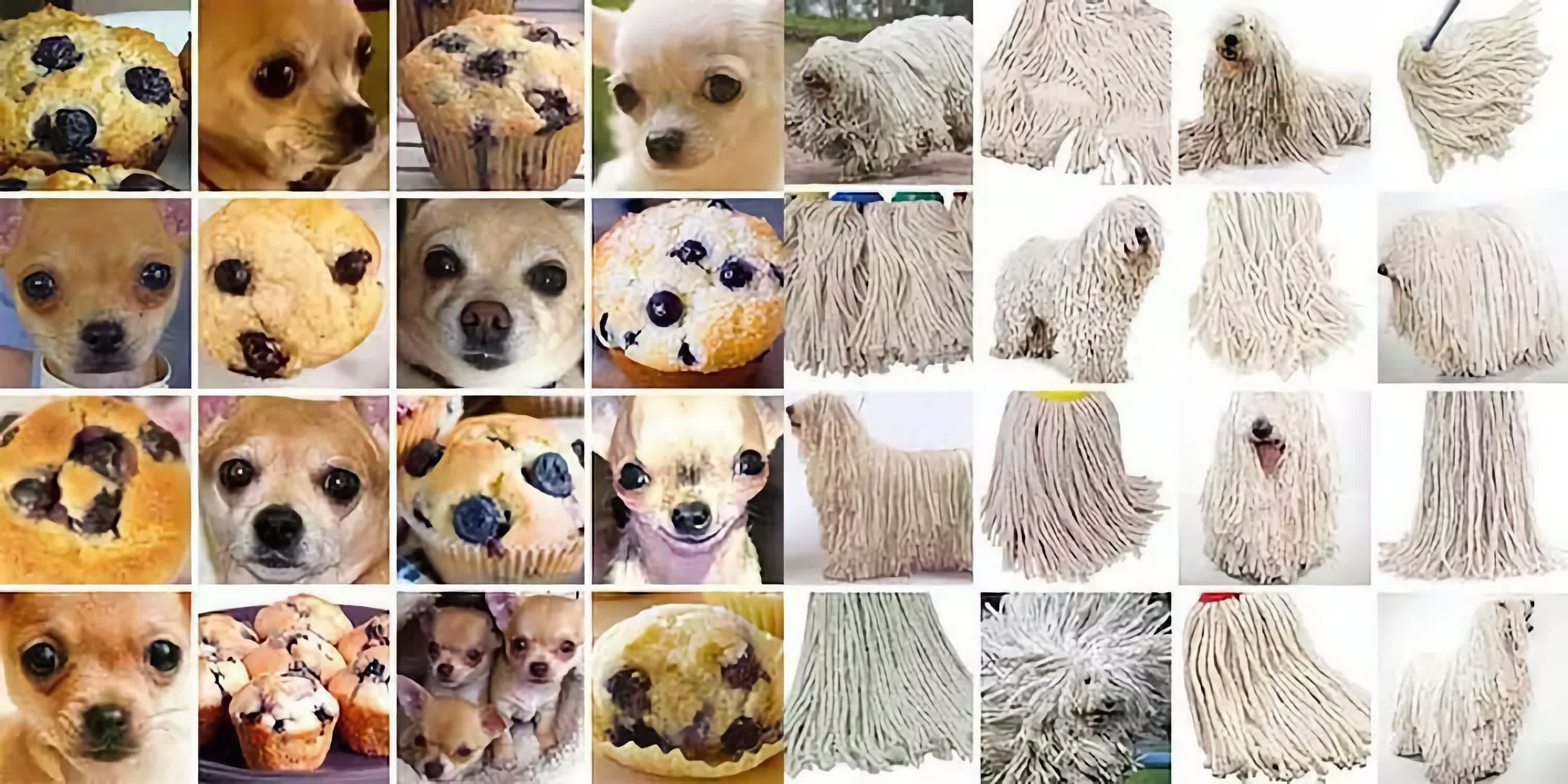

Смешно, но факт: нейросети могут путать чихуахуа с черничными маффинами, а пуделей со швабрами. На первый взгляд это забавно, но за такими ошибками стоит важный и тревожный феномен — «галлюцинации» искусственного интеллекта. Этот термин всё чаще используют исследователи и разработчики, чтобы описать ситуацию, когда ИИ производит убедительную, но совершенно ложную информацию.

Исследователи в области информационных технологий, изучают такие ошибки, особенно в системах распознавания речи. Но «галлюцинации» встречаются повсеместно — от чат-ботов вроде ChatGPT до генераторов изображений вроде DALL-E и автопилотов в автомобилях. И чем глубже ИИ проникает в повседневную жизнь, тем опаснее становится его склонность к фантазиям.

(НЕ) безобидные ошибки

Ошибки ИИ могут быть безобидными, например, когда чат-бот путает факты. Но иногда они имеют серьёзные последствия: неверное медицинское заключение, ошибочная рекомендация юристу или сбой в работе автопилота могут стоить человеку жизни.

Главная проблема в том, что люди склонны верить ИИ на слово. Его ответы звучат уверенно, логично и грамотно — даже когда они абсолютно неверны. В результате люди могут принять ложную информацию за истину, что особенно опасно в таких сферах, как медицина, страхование или юриспруденция.

Один из ярких примеров произошёл в Нью-Йорке в 2023 году, когда адвокат использовал ChatGPT для подготовки судебного документа. В результате в нём оказались ссылки на несуществующие дела. Если бы судья не заметил подвоха, последствия могли бы быть серьёзными. И это совсем не единичный случай.

Что именно считается «галлюцинацией»?

У разных ИИ-систем «галлюцинации» проявляются по-разному. У текстовых моделей это может быть выдуманная цитата, ложный исторический факт или ссылке на статью, которой никогда не существовало.

У систем компьютерного зрения — это, например, описание объектов на изображении, которых там нет. Представьте: вы показываете ИИ фото женщины, говорящей по телефону, а он уверенно утверждает, что она сидит на скамейке, хотя этого не видно. В случае с системами наблюдения или распознавания объектов такая ошибка может привести к фатальным последствиям.

А системы распознавания речи могут «услышать» слова, которых не было, особенно в шумной обстановке. Например, вы записываете медицинское заключение, а ИИ случайно добавляет туда лишние симптомы из-за фонового шума — и пациенту ставят неверный диагноз.

Откуда берутся эти ошибки?

ИИ обучают на огромных объёмах данных. Алгоритмы изучают закономерности и учатся предугадывать, что «должно» следовать за тем или иным входом. Но если данные неполные, предвзятые или не охватывают нужный контекст — ИИ начинает «додумывать».

Иногда модель просто не понимает, чего от неё хотят, и «заполняет пробелы» тем, что кажется ей логичным — на основе обучения. Так маффин превращается в чихуахуа. Особенно часто это случается, когда ИИ сталкивается с новыми или редкими ситуациями, которых не было в тренировочной выборке.

Важно отличать такие «галлюцинации» от творческого поведения ИИ. Когда вы просите нейросеть написать рассказ или нарисовать картину, вы ждёте вымысел. Но если вы хотите точный факт или диагноз, а получаете выдумку — это уже опасно.

Как с этим бороться?

Компании-разработчики уже работают над решением этой проблемы. Один из подходов — улучшение качества обучающих данных и внедрение ограничений на типы допустимых ответов. Но даже это не даёт гарантии, что ошибки исчезнут полностью.

Поэтому главный совет — не доверяйте ИИ вслепую. Всегда проверяйте информацию, особенно в важных вопросах. Сравнивайте с надёжными источниками, обращайтесь к специалистам, если сомневаетесь. И главное — помните, что ИИ может звучать умно, но это не значит, что он прав.

ИИ — это инструмент, а не истина в последней инстанции. И пока он учится, ответственность за правильность решений остаётся за человеком.

Ещё по теме:

- Китайская корпорация могла завербовать тайваньских инженеров, притворившись фирмой с Самоа

- Почему Apple «забыла» про базовый iPad? Искусственное ограничение в действии

- Российские пользователи iPhone остаются верны Apple, несмотря на тренды