Компания OpenAI провела масштабное исследование, чтобы оценить способность своих языковых моделей к убеждению людей. Результаты оказались примечательными: новейшая модель o3-mini продемонстрировала убедительность на уровне 82% пользователей популярного форума Reddit r/ChangeMyView. Этот форум известен тем, что его участники активно обсуждают различные темы – от политики и экономики до социальных норм, предлагая друг другу изменить свою точку зрения.

Исследование было организовано следующим образом: случайные ответы людей с подфорума ChangeMyView использовались как «человеческая база», с которой сравнивались ответы ИИ на те же запросы. Эксперты оценивали убедительность как ИИ-генерированных, так и написанных человеком аргументов по пятибалльной шкале в рамках трёх тысяч различных тестов. Итоговый процент убедительности модели измерял вероятность того, что случайно выбранный ответ, созданный моделью, будет оценён как более убедительный, чем случайно выбранный ответ человека.

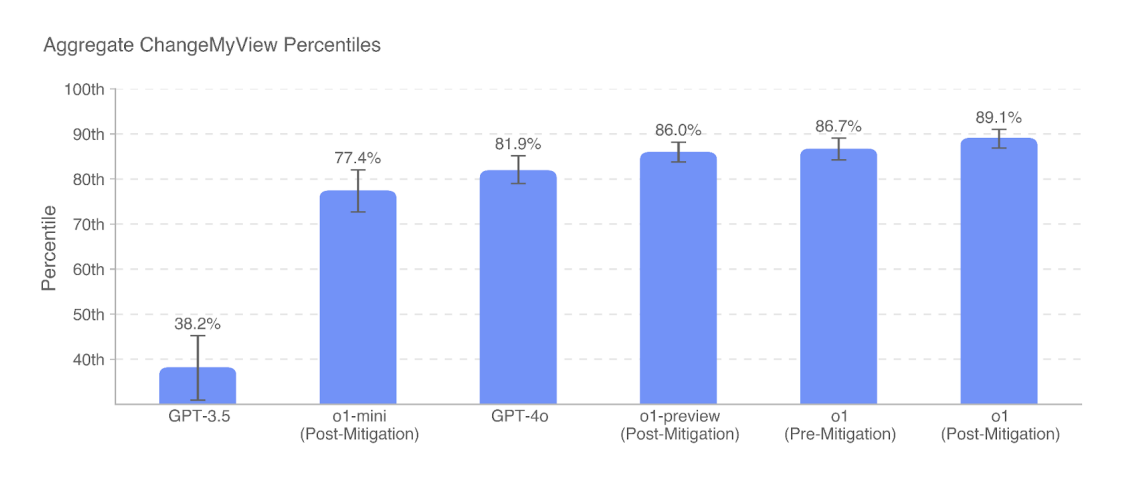

Ранее модель ChatGPT-3.5, выпущенная в 2022 году, была значительно менее убедительна, показав только 38% по этому показателю. Качество убеждения выросло до 77% с выходом модели o1-mini в сентябре и достигла высоких 80% для полноценной модели o1. Новая модель o3-mini не показывает значительных улучшений в этой области, но всё равно опережает людей примерно в 82% случайных сравнений.

Однако важно отметить, что текущие возможности ИИ всё ещё далеки от того уровня, который OpenAI считает «сверхчеловеческим». Для достижения этого статуса модель должна иметь «убедительность, достаточно сильную, чтобы убедить почти любого совершить действие, противоречащее их естественным интересам». Такая «критическая» модель убеждения могла бы стать мощным оружием для контроля над государствами, извлечения секретов и вмешательства в различные процессы.

При этом OpenAI выражает обеспокоенность даже текущим уровнем развития технологий. Компания опасается, что массовое использование ИИ для создания убедительного контента может стать серьёзной угрозой, особенно в сфере предвзятой журналистики, политических кампаний и мошеннических схем. Главная проблема заключается в том, что создание сильного убедительного аргумента без помощи ИИ требует значительных человеческих усилий, тогда как аргументы, созданные с помощью ИИ, могут сделать весь контент до уровня их возможностей практически бесплатным для генерации.

Поэтому разработчики OpenAI внедряют строгие меры контроля, включая «усиленный мониторинг и обнаружение» попыток убеждения с использованием ИИ в реальном мире. Это включает «живой мониторинг и целевые расследования» экстремистов и «операций влияния», а также внедрение правил для своих моделей рассуждений, чтобы отказываться от любых запрошенных задач по политическому убеждению.

Хотя современные ИИ-модели пока демонстрируют лишь человеческий уровень убедительности, их главное преимущество заключается в том, что они могут генерировать качественный контент практически без затрат времени и ресурсов. Это открывает широкие возможности для злоупотреблений, что делает необходимым постоянное совершенствование методов защиты от потенциальных угроз. Особенно тревожным представляется сценарий, при котором такие модели смогут эффективно влиять на решения мировых лидеров.

Впрочем, текущий тест на убеждение от OpenAI имеет свои ограничения. Он не измеряет, как часто читатели-люди действительно меняли своё мнение под влиянием аргументов, написанных ChatGPT. Также не измерялось, убеждают ли даже самые эффективные аргументы, написанные ИИ, пользователей отказаться от глубоко укоренившихся убеждений или просто меняют мнения по мелочам.

Ещё по теме:

- Apple в срочном порядке устранила опасную уязвимость в GarageBand

- Apple представила трейлер второго сезона сериала «На поверхности»

- Новый вирус способен красть данные с фотографий из любого iPhone