Головоломки из видеоигр неожиданно оказались идеальным полигоном для проверки способностей искусственного интеллекта к сложному планированию. Классическая задача из серии The Legend of Zelda с переключением цветов показала, насколько далеко продвинулись современные языковые модели в умении «думать» на несколько шагов вперёд.

Эксперимент, проведённый изданием The Decoder, выявил интересную динамику: пока одни нейросети щёлкают такие задачи как орешки, другие тратят на решение десятки страниц текста, перебирая варианты методом проб и ошибок.

В чём суть теста

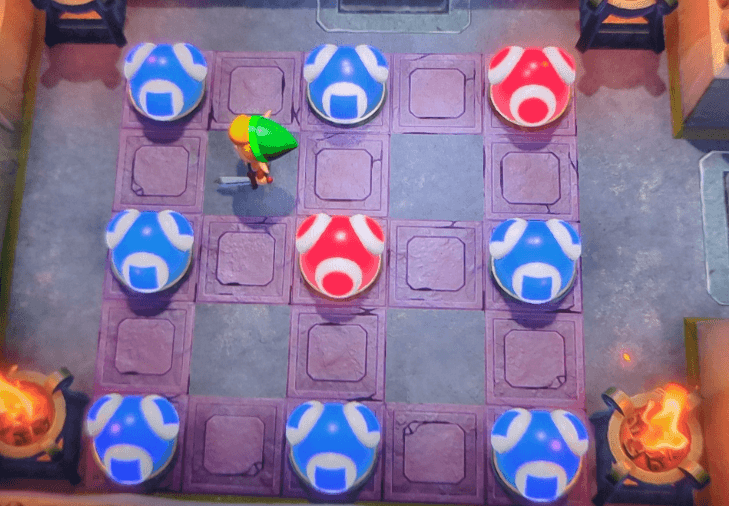

Для эксперимента использовалась механика, знакомая фанатам старых частей Zelda. Правила элементарны:

- Есть поле с красными и синими сферами.

- Удар по сфере меняет её цвет на противоположный.

- Одновременно меняется цвет всех соседних сфер (сверху, снизу, слева и справа).

- Цель: сделать так, чтобы все сферы стали синими.

Сложность заключается в том, что каждое действие меняет состояние всей системы. Чтобы решить такую задачу, нужно просчитать последствия своих ходов заранее — в данном случае требовалось планирование на шесть ходов вперёд.

Битва титанов: GPT-5.2 против Gemini 3 и Claude Opus

Автор эксперимента «скормил» скриншот головоломки трём ведущим моделям, предварительно изменив начальные условия, чтобы исключить возможность простого поиска готового решения в интернете.

GPT-5.2-Thinking (OpenAI) показала безупречный результат. Модель каждый раз находила верную последовательность действий быстро и надёжно, демонстрируя способность к эффективному абстрактному мышлению.

Gemini 3 Pro (Google) справилась с задачей, но процесс оказался мучительным. Нейросеть часто уходила в бесконечный перебор вариантов, иногда генерируя до 42 страниц текста с попытками найти решение методом «тыка». Хотя ответ в итоге был найден, эффективность такого подхода оказалась под вопросом.

Claude Opus 4.5 (Anthropic) изначально провалила тест. Система не смогла корректно интерпретировать визуальные данные со скриншота. Только после того, как автор предоставил дополнительные текстовые пояснения, модель смогла решить задачу, применив математические уравнения для расчёта ходов.

Конец эпохи авторских гайдов?

Успех «рассуждающих» моделей в решении игровых задач открывает дорогу к полной автоматизации создания контента для геймеров. Если объединить аналитические способности GPT-5.2 с автономными агентами, способными самостоятельно управлять игровым персонажем, потребность в написанных людьми прохождениях может полностью исчезнуть.

Яркий пример такого будущего — технология Nvidia NitroGen. Этот ИИ-агент обучается на тысячах часов видеозаписей игрового процесса и может самостоятельно проходить игры, документируя каждое действие. Система способна автоматически создавать пошаговые инструкции со скриншотами.

В перспективе подобные связки «думающих» и «действующих» нейросетей смогут не только писать гайды для игр, но и генерировать документацию для любого сложного программного обеспечения, просто наблюдая за его работой.