Компания Apple выпускает набор функций на своих платформах, направленных на защиту детей в Интернете, включая систему, которая может обнаруживать материалы о насилии над детьми в iCloud, сохраняя при этом конфиденциальность пользователей.

В четверг технологический гигант из Купертино объявил о новых функциях детской безопасности в трёх областях, которые, по его словам, помогут защитить ребёнка от злоумышленников и ограничить распространение материалов о сексуальном насилии над детьми (CSAM – Child Sexual Abuse Material; материалы о сексуальном насилии над детьми). Официальное объявление последовало сразу за сообщениями о том, что Apple собирается запустить некую систему для борьбы с CSAM на своих платформах.

«Наша цель в Apple – создавать технологии, которые расширяют возможности людей и обогащают их жизнь, помогая при этом оставаться в безопасности», – говорится в пресс-релизе компании.

Например, Apple внедрит новые инструменты в Сообщения, которые позволят родителям быть более информированными о том, как их дети общаются в Интернете. Компания также использует новую систему, использующую криптографические методы для обнаружения коллекций CSAM, хранящихся в iCloud Photos, чтобы предоставить информацию правоохранительным органам. Apple также работает над новыми инструментами безопасности в Siri и Поиске.

«Расширенная защита детей от Apple – это изменение в правилах игры» – сказал Джон Кларк, генеральный директор и президент Национального центра по поиску пропавших и эксплуатируемых детей.

Поскольку продукцией Apple пользуется так много людей, новые меры безопасности могут спасти жизнь детям, которых пытаются соблазнить в Интернете и чьи ужасные изображения распространяются в материалах о сексуальном насилии над ними. В Национальном центре помощи пропавшим и эксплуатируемым детям мы знаем, что с такими преступлениями можно бороться только в том случае, если мы будем неуклонно защищать своих детей. Мы можем сделать это только потому, что технологические партнёры, такие как Apple, делают шаг вперёд и заявляют о своей готовности в работе над проблемой. Реальность такова, что частная жизнь и защита детей могут сосуществовать. Мы приветствуем компанию Apple и надеемся на совместную работу, чтобы сделать этот мир более безопасным для жизни детей.

Все три функции также были оптимизированы для обеспечения конфиденциальности, гарантируя, что Apple сможет предоставлять информацию о преступной деятельности соответствующим органам без угрозы для частной информации законопослушных пользователей.

Новые функции появятся позже в 2021 году в обновлениях iOS 15, iPadOS 15, macOS Monterey и watchOS 8.

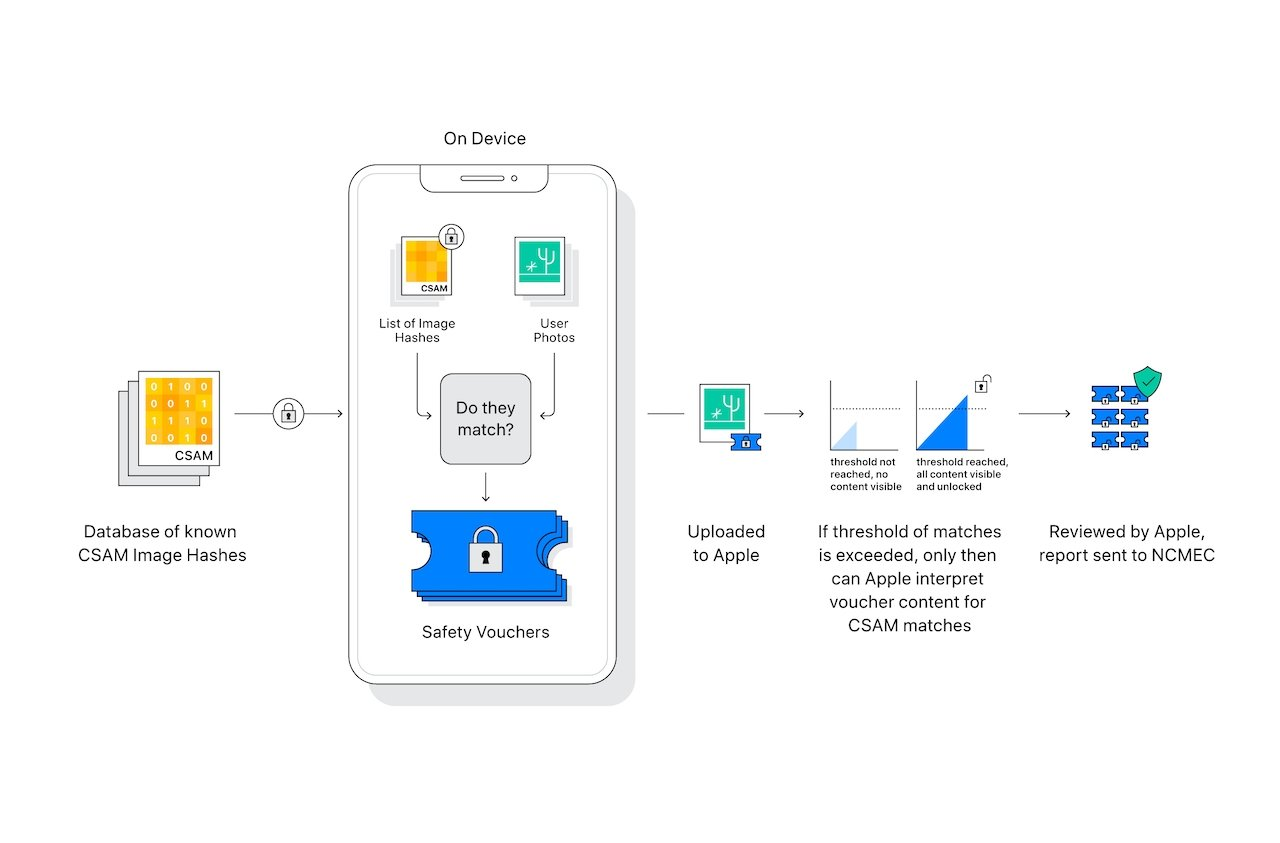

Обнаружение CSAM в iCloud Photos

Самая значимая из новых функций безопасности детей, которую планирует представить Apple, касается обнаружения CSAM в аккаунтах iCloud Photos.

Если Apple обнаружит хранящиеся в iCloud коллекции CSAM, она пометит этот аккаунт и предоставит информацию в NCMEC (Национальный центр по поиску пропавших и эксплуатируемых детей), который работает как центр информирования о материалах о насилии над детьми и сотрудничает с правоохранительными органами по всей территории США.

Apple не сканирует изображения. Вместо этого она использует интеллектуальные возможности устройства, чтобы сопоставить CSAM-изображения с известной базой данных хэшей, предоставленной NCMEC и другими организациями по детской безопасности. Эта база данных преобразуется в нечитаемый набор хэшей, который надежно хранится на устройстве пользователя.

Сам метод обнаружения CSAM в iCloud Photos сложен и использует криптографические методы на каждом этапе для обеспечения точности и сохранения конфиденциальности для обычного пользователя.

Apple заявляет, что помеченный аккаунт будет отключен после ручной проверки. После отключения аккаунта компания из Купертино отправит сообщение в NCMEC. У пользователей будет возможность обжаловать отключение аккаунта, если они считают, что их ошибочно выбрали в качестве объекта для проверки.

Компания снова подчеркивает, что функция обнаруживает только CSAM-фотографии, хранящиеся в iCloud Photos – она не будет применяться к фотографиям, хранящимся исключительно на устройстве. Кроме того, Apple утверждает, что частота ошибок в системе составляет менее одной на один триллион аккаунтов в год.

Одного фрагмента оскорбительного материала недостаточно для срабатывания функции, что позволяет сократить количество ложных срабатываний.

Опять же, Apple утверждает, что она будет изучать только те изображения, которые соответствуют известным CSAM-изображениям. Система не сканирует каждое изображение, хранящееся в iCloud, и не будет получать или просматривать изображения, которые не соответствуют уже известным.

Система обнаружения CSAM будет применяться только к учетным записям iCloud, расположенным в США. Apple заявляет, что в будущем она, вероятно, распространит эту систему на более широкую область.

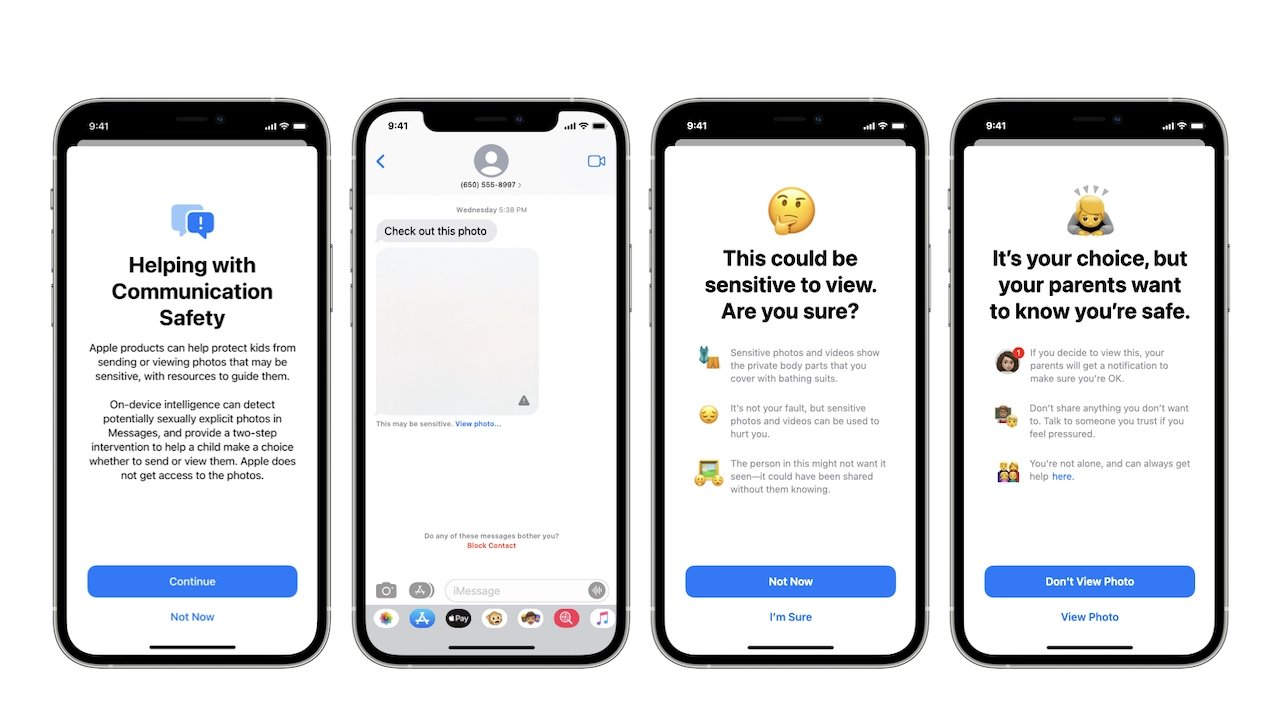

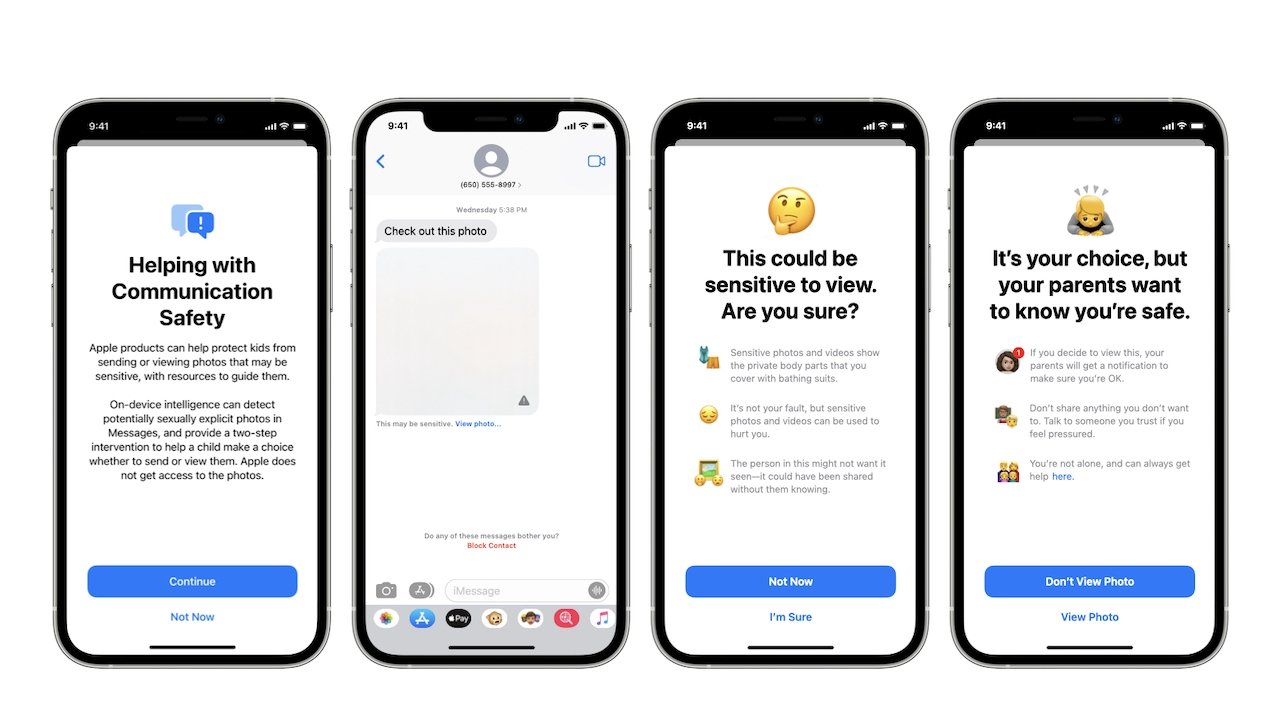

Безопасность коммуникаций

Одно из обновлений направлено на повышение безопасности детей, общающихся в Интернете с помощью iMessage от Apple.

Например, приложение iMessage теперь будет показывать предупреждения для детей и родителей, когда они получают или отправляют фотографии сексуального характера.

Если ребёнок младше 17 лет получит деликатное изображение, оно будет автоматически размыто, и ему будут предложены полезные вспомогательные ресурсы. Apple также включила механизм, который позволит детям младше 13 лет узнать, что в случае просмотра изображения информация об этом будет отправлена родителям. Дети в возрасте от 13 до 17 лет не будут получать уведомление от родителей при открытии таких изображений, а функция Communication Safety не может быть включена в учетных записях, используемых взрослыми старше 18 лет.

Система использует машинное обучение на устройстве для анализа изображений и определения, является ли оно сексуально-ориентированным. Она специально разработана таким образом, чтобы Apple не получала и не могла получить копию изображения.

Обновления Siri и Поиска

В дополнение к функциям безопасности iMessage, Apple также расширяет инструменты и ресурсы, которые она предлагает в Siri и Поиске, когда речь заходит о безопасности детей в Интернете.

Например, пользователи iPhone и iPad смогут спросить Siri, как они могут сообщить о CSAM-изображениях или эксплуатации детей. Siri предоставит соответствующие ресурсы и рекомендации.

Siri и Поиск также будут обновлены, чтобы вмешаться, если пользователи выполнят поиск или запрос на CSAM. Как отмечает Apple, эти действия объяснят пользователям, что интерес к этой теме вреден и проблематичен, и предоставят ресурсы от партнеров для получения помощи в решении этой ситуации.

Сохранение конфиденциальности пользователей

Apple уже давно заявляет о том, что прилагает все усилия для защиты конфиденциальности пользователей. Компания даже вступала в противостояние с правоохранительными органами по поводу прав пользователей на их конфиденциальность. Поэтому внедрение системы, предназначенной для предоставления информации правоохранительным органам, вызывает беспокойство у некоторых экспертов по безопасности.

This sort of tool can be a boon for finding child pornography in people’s phones. But imagine what it could do in the hands of an authoritarian government? https://t.co/nB8S6hmLE3

— Matthew Green (@matthew_d_green) August 5, 2021

Однако компания утверждает, что при разработке системы слежка и злоупотребление ею были "первоочередной задачей". Apple заявляет, что каждая функция была разработана таким образом, чтобы обеспечить сохранение конфиденциальности при противодействии CSAM или эксплуатации детей в Интернете.

Например, система обнаружения CSAM с самого начала была разработана только для обнаружения CSAM – она не содержит механизмов для анализа или обнаружения любого другого типа фотографий. Более того, она обнаруживает только коллекции CSAM, превышающие определенный показатель.

Apple отмечает, что система не позволяет вести слежку и не ослабляет шифрование.

Эксперты по безопасности все еще обеспокоены последствиями. Мэтью Грин, профессор криптографии из Университета Джона Хопкинса, отмечает, что хэши основаны на базе данных, которую пользователи не могут проверить самостоятельно.

Росс Андерсон, профессор кафедры техники безопасности Кембриджского университета, назвал эту систему «абсолютно ужасной идеей» в интервью газете Financial Times. Он добавил, что это может привести к распределенной массовой слежке за телефонами и ноутбуками.

Группа по защите цифровых прав Electronic Frontier Foundation также написала сообщение в своём блоге об этой функции, заявив, что она открывает дверь для более масштабных злоупотреблений.

«Чтобы расширить узкий черный ход, который создает Apple, достаточно расширить параметры машинного обучения для поиска дополнительных типов контента или изменить флаги конфигурации, чтобы сканировать не только детские, но и любые другие учетные записи. Это не скользкая дорожка; это полностью готовая система, которая только и ждет внешнего давления, чтобы внести в неё малейшие изменения», – написали сотрудники EFF Индия Маккинни и Эрика Портной.

Ещё по теме:

- В сети появилось видео прототипа AirPower

- Уолтер Айзексон напишет биографию Илона Маска

- Единая карта петербуржца теперь работает с Apple Pay