Системы ИИ, работающие в режиме генерации текста, стали в два раза чаще выдавать фальшивые сведения в ответах на вопросы, касающиеся текущих событий.

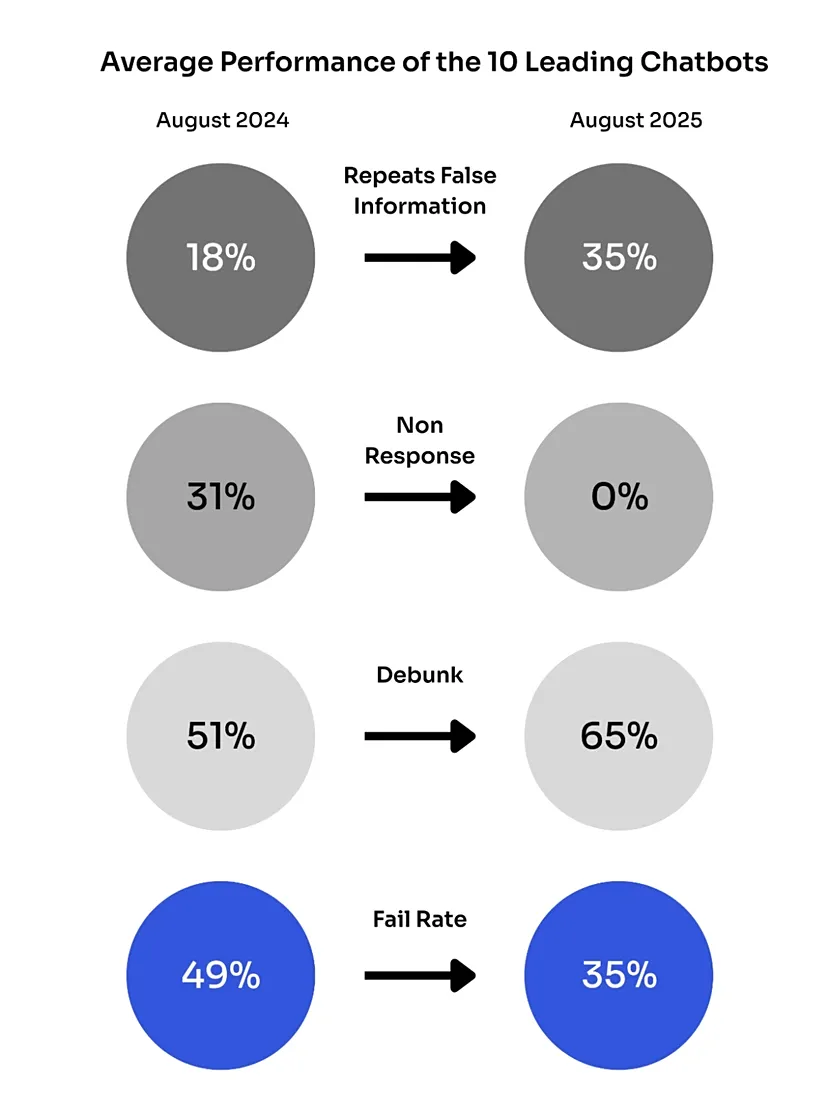

По анализу, подготовленному исследовательской организацией Newsguard, в августе 2025 года десять крупнейших платформ на базе нейросетей в 35% случаев распространяли дезинформацию. Для сравнения, летом 2024 года этот показатель составлял 18%.

Причиной ухудшения ситуации исследователи называют массовое внедрение в чат-боты функций онлайн-доступа к интернету.

По сути, системы стали напрямую черпать сведения из цифровой среды, переполненной манипуляциями и ложными источниками. Авторы отчёта говорят, что теперь ИИ не просто генерирует текст, а делает это на основе заражённых массивов данных, не отличая правду от фабрикаций.

В 2024 году алгоритмы отказывались отвечать на более трети потенциально чувствительных запросов — таких отказов фиксировалось до 31%. Сейчас же фильтрация практически исчезла, т. к. система выдаёт ответы на всё без исключений, в том числе темы, где возможна дезинформация.

Отдельно исследователи отмечают рост числа веб-сайтов, специально созданных для распространения ложных материалов. В 2024 году выявлено 966 подобных ресурсов. Новые алгоритмы, способные получать доступ к интернету, начинают использовать данные с этих площадок как полноценные источники, не анализируя достоверность.

Худшие показатели продемонстрировала модель Inflection, где 56,67% ответов оказались неточными или вводящими в заблуждение. За ней следуют Perplexity с 46,67%, ChatGPT и ИИ от Meta* — по 40%, Copilot и Mistral — около 36%. Наименее подверженными искажениям оказались Claude (10%) и Gemini (16,67%).

Ещё по теме:

- Человек, повлиявший на OpenAI, призывал уничтожить центры обработки данных ИИ

- В Китае начали антидемпинговое расследование против американских чипов

- Apple Glass без AR выйдут в конце 2026 — начале 2027 года