В последнее время новые технологии развиваются все быстрее, поражая наше воображение, и, вопреки скептикам, плотно занимают свое место в современном мире. Некоторые из них вдохновляют, предоставляя самым расторопным, возможность неплохо заработать, как, например, криптовалюты или NFT.

Какие-то, вроде электрокаров и биоразлагающихся материалов, призваны спасти планету от пагубного воздействия человеческой деятельности, и поэтому, вселяют надежду на светлое будущее. Но есть и такие, которые, мягко говоря, настораживают, а то и вовсе пугают.

Мы все давно привыкли к фейкам в статичных изображениях, то есть в фотографиях. Картинки с несуществующими животными, ландшафтами и людьми уже никого не удивляют.

Каждый опытный пользователь всемирной сети давно взял за правило ставить под сомнение подлинность любого изображения, встречающегося ему на просторах интернета. Никого больше не ошарашить крутыми спецэффектами на экране, суперреалистичной графикой, взрывами и драконами.

Но лишь совсем недавно появилась возможность качественно изменять на видео человеческое лицо. Причем не имея под рукой команды CGI-художников из Disney. Все благодаря технологии DeepFake.

Почти все уже смотрели эти видео с Томом Крузом, Николасом Кейджем и другими известными людьми. И многие из них пугающе реалистичны. Что же это значит? Теперь кто угодно может притвориться кем угодно? Может ли кто-то сделать дипфейк с Вашим лицом?

Это сложная супертехнология, подвластная лишь просвященным, или с этим справится каждый? Сегодня Вы узнаете ответы на эти вопросы, но, обо всем по порядку. Давайте разберемся в том, что такое дипфейки.

Что такое дипфейки?

Сейчас, когда кто-то говорит о дипфейках, скорее всего он имеет в виду те самые видео с заменой лица. Однако, они лишь часть всего того, что имеет право так именоваться. Лицо на видео можно не только заменить, но также омолодить или состарить.

А еще можно заставить человека на видео говорить на незнакомых языках. Существуют также аудиофейки, которые подделывают голоса. И все это сейчас возможно, благодаря нейросетям и их способности к глубокому обучению – deep learning. От этого понятия и берет свое начало термин deepfake.

И хотя область применения технологии обширна, и не стоит воспринимать ее только как инструмент для замены лиц, начиналось все именно так.

В 2014 году эту технологию создал Ян Гудфеллоу, на тот момент студент Стэндфордском университете, а ныне – директор по машинному обучению в группе специальных проектов в Apple.

Едва ли он тогда подозревал, что пройдет три года и плод его трудов найдет свое оригинальное применение. Один из пользователей Reddit с ником «Deepfakes» начал с его помощью заменять лица актрис в порно видео лицами знаменитостей.

Тогда Reddit конечно отреагировал и ужесточил свои ограничения в распространении контента, а название «дипфейки» закрепилось за аналогичными подделками с видео или аудио манипуляцией.

Как они работают?

Как уже было сказано, при создании дипфейков используются генеративно-состязательные нейросети. Это некие алгоритмы, созданные на основе машинного обучения и способные создавать новый контент из исходного набора.

Для понимания принципа их действия, давайте представим такую аналогию. Есть студент, которые делает проект, и есть преподаватель, который проверяет его работу, каждый раз находя новые ошибки и погрешности и отправляя его домой все исправлять и переделывать. И так до тех пор, пока результат его не удовлетворит.

Алгоритм устроен схожим образом: одна его часть учится на реальных фотографиях объекта и генерирует новые изображения, а в это время вторая ищет в них неточности. Например, используя в качестве исходного материала для обучения тысячу фотографий голливудской звезды Марго Робби, нейросеть может создать новую, сохранив черты лица и мимику актрисы.

А если взять больше материала и потратить много времени, вполне возможно сделать так, что Марго будет сама вам об этом рассказывать. Здорово, правда?

Зачем нам нейросети?

Нейросети появились не так давно, по сравнению с эффектами и графикой в кино. Почему же эти технологии, благодаря которым мы видим на экране такие реалистичные взрывы, межпланетные перелеты и фантастические города, вдруг ощутили проблемы при работе с человеческим лицом?

Дело в том, что лицо – самое интересное для человеческих глаз место в любом существующем контенте с участием людей. БОльшую часть времени в сцене, где присутствует человек, мы смотрим на его лицо. Эволюционно мы все научились различать миллионы малейших изменений в мимике другого человека, говорящие нам о переменах настроения и переживаемых эмоциях.

Поэтому и подделать все эти бесчисленные комбинации выражений лица – задача непростая. Было предпринято множество попыток нарисовать человеческое лицо реалистичным при помощи CGI. Но даже избежав видимых погрешностей, создатели сталкивались с эффектом зловещей долины.

Это такое занятное явление, основывающееся на гипотезе японского инженера и учёного Масахиро Мори. Она гласит, что робот или иной объект, внешне похожий на человека, но не являющийся в точности таким же, вызывает неприязнь и отвращение у людей-наблюдателей.

Иными словами, мы с вами можем и не заметить никаких очевидных признаков подделки, вроде неточностей или размытости, но при этом все равно ощутим, что что-то тут не так.

Это наш мозг не признает в увиденном реального человека и шлет нам об этом сигнал. А если перед нами не человек, то это что-то иное, неизвестное и непредсказуемое. А значит – опасное.

Так эволюционно устроен наш мозг. Видишь что-то очень большое – беги оттуда, скорее всего оно опасно для тебя. Что-то непонятное – тоже, на всякий случай, беги. А раз человека идентифицировать не удалось, значит непонятно, что это такое перед нами. И мы начинаем испытывать тревогу.

Потому что даже команда профессиональных художников не сможет в точности воссоздать всю многогранную мимику и экспрессию человеческого лица.

А вот нейросети, постоянно обучаясь и совершенствуясь на основе корректных данных, продвинулись в этом куда дальше. И многие сейчас говорят, что повсеместное признание и использование нейросетей для генерирования контента – это только вопрос времени.

«Сферу рекламы и развлечений ожидает этап бурного роста применения дипфейков. Пока он сдерживается технологическими сложностями и некоторыми правовыми аспектами, но это вопрос времени.

Мы знаем опыт цифровой реинкарнации в кино, когда создатели блокбастеров «возвращают к жизни» давно ушедших актеров.

Например, получил цифровую копию в «Изгой-один: Звёздные войны» Питер Кушинг, который покинул мир четверть века назад, а в 2013-м в рекламном ролике шоколада «снималась» молодая Одри Хепберн.

Цифровых двойников активно используют в кино и deepfake подтолкнет рынок к оцифровке виртуальных актеров» - заявляет Сергей Житинец, генеральный директор Motive agency&productionv.

Где применяются дипфейки?

Практически везде, где можно использовать видео или звук. Фильмы, видео, записи голосов — во всех этих сферах применяются дипфейки.

Например, в фильме «Хан Соло. Звёздные войны: истории» с помощью дипфейк-технологий «омолодили» Хана Соло, которого играл Харрисон Форд. Таким же образом омолаживали Джо Пеши, Аль-Пачино и Роберта Де Ниро в недавнем «Ирландце» Мартина Скорсезе.

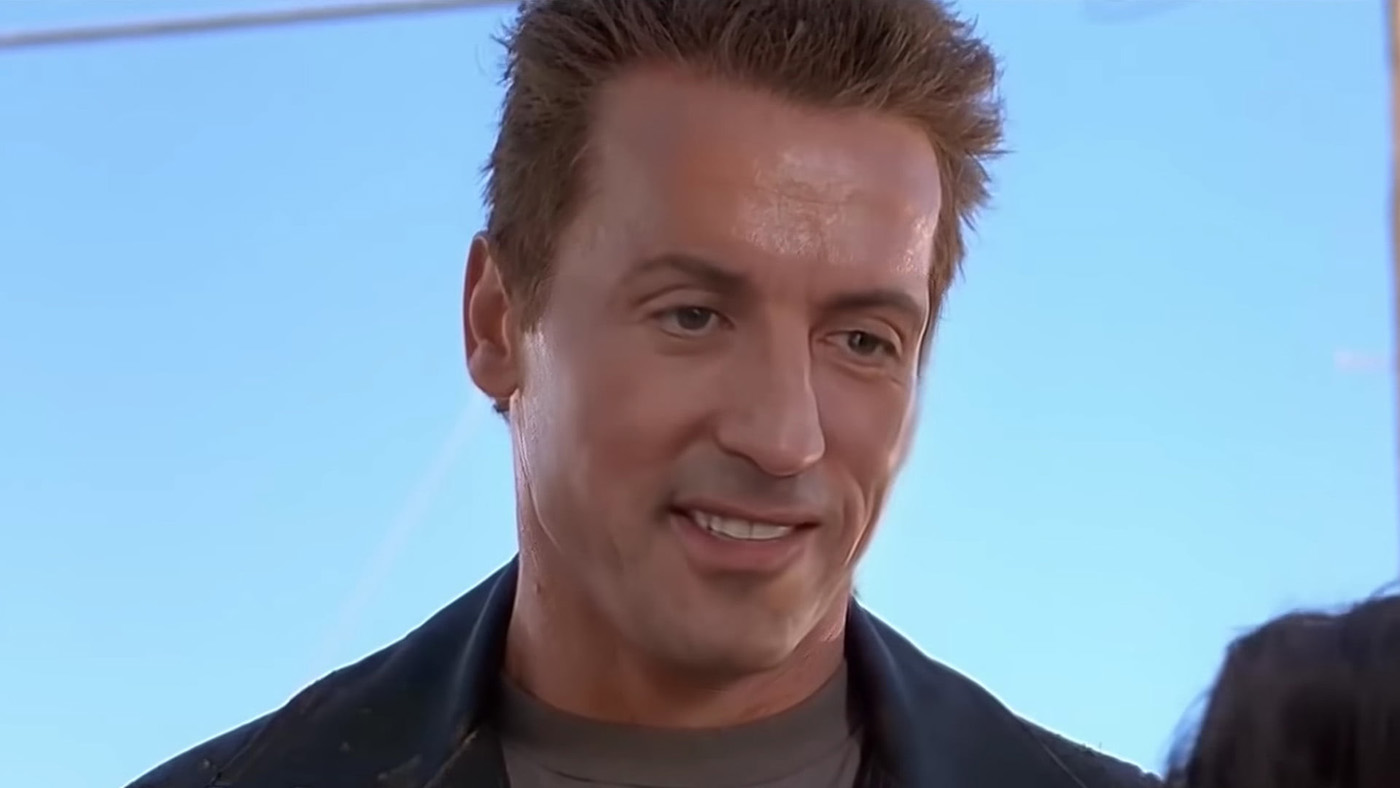

В сети много развлекательных роликов с дипфейками. Так, на youtube-канале Ctrl Shift Face автор меняет лица главных героев фильма на других известных голливудских актеров.

В его роликах Сильвестр Сталлоне становится Терминатором, Брюс Ли исполняет роль Нео в «Матрице», а Джим Керри вместо Джека Николсона играет главную роль в «Сиянии».

Развитий у технологии может быть множество, говорит Парамон Парфёнов, креативный директор Dada Agency «Например, Киану Ривз может продать своё лицо и сняться в рекламе Пятерочки, даже не приезжая в Москву.

По идее, цена за такой “прокат” должна быть ниже. Продакшены могут внедрить технологию в цикл производства и предлагать лица 3D-актеров или вообще создать собственного.

Клиент может сам создавать своих актеров и снимать ролики с ними. Ещё лучше, если снимать один ролик, но менять лица актеров в зависимости от целевой аудитории. Это же мечта маркетолога. Каждый потребитель будет видеть то, что он любит».

Масса перспектив в будущем, но на нынешний момент исследования говорят, что 96% дипфейков в интернете — порноролики. Помимо порнографии пользователи в интернете интересуются еще и политикой.

В сети есть несколько дипфейков с политическими деятелями, где их выступления монтировали и меняли смысл высказывания. Пьяная Нэнси Пелоси, Трамп, выступающий против климатических инициатив, а также Обама, который в одном из роликов назвал Трампа complete dipshit (засранцем).

Конечно, в реальности никто из них этого не делал, но доказали это не сразу.

Как создать своё дипфейк?

Есть много разных программ для выполнения отдельных задач. Одни помогут Вам заменить лицо на видео на совершенно другого человека, другие – изменить движения губ говорящего, а третьи – сгенерировать новую звуковую дорожку с голосом.

Необходимо понимать, что приложение, в котором можно с помощью одной лишь фотографии вставить себя в отрывок фильма или мем, требует совершенно иных вычислительных мощностей, нежели программы для создания качественных реалистичных дипфейков.

Затраты по времени и объемы исходного материала также будут заметно разниться. Но и результаты, соответственно, будут совершенно разного уровня.

Наиболее популярной программой для создания такого контента можно смело назвать DeepFaceLab. По заверениям создателей продукта, с его помощью создаётся около 95% всего дипфейк-видеоконтента. Скачать программу можно с ГитХаба.

Примеры более простых программ: FakeApp, ZAO, Reface. У каждой из них есть свои нюансы, как, например, необходимость специфических знаний или оплаты подписки. Но определенного результата с их помощью Вы достигнете.

Кстати, теперь существует также технология DeepFace Live, которая позволяет производить замену лица не на записи, а в прямом эфире. Например, если Вы сидите перед веб-камерой и общаетесь по видеосвязи.

В целом, технология на определенном уровне сейчас доступна практически каждому пользователю. Иными словами, почти любой может сам сделать дипфейк. Но чтобы сделать его хорошо, придется потратить много сил и времени.

И да, теоретически можно сделать дипфейк и с Вашим лицом, если собрать достаточную базу материалов с Вами для обучения нейросети.

Вообще в свободном доступе есть готовые модели многих известных личностей, как, например, новой подруги Джеймса Бонда – Анны де Армас. Но все-таки, если Вы не суперзвезда, и в сети не так много качественно снятого контента с Вашим участием, сделать это будет проблематично.

Есть вариант для тех из нас, кто не ищет легких путей – теоретически можно создать свою нейросеть и обучить её. Однако этот вариант — дорогой, сложный и маловероятный в сегодняшних реалиях. А посему мы его опустим как околомифический.

Как дипфейки могут помочь людям?

Пока что дипфейк-контент особого влияния жизнь широких масс не оказывает. За исключением, разве что, исполнения своей развлекательной функции.

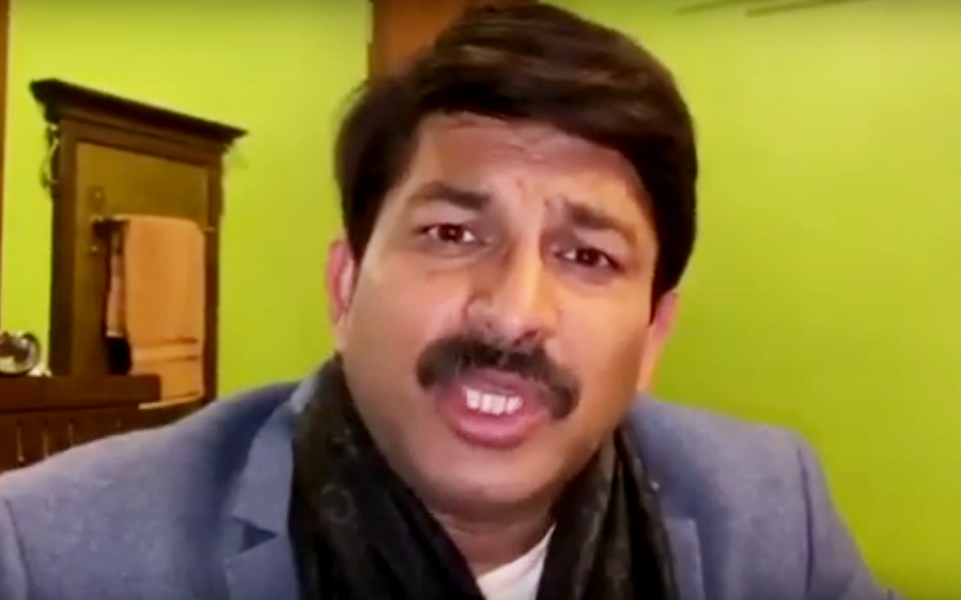

Однако дипфейки, созданные для какой-либо конкретной цели, могут иметь большой эффект. Как пример, в 2020 году партия Джаната в ходе избирательной компании в законодательное собрание Дели применила дипфейк контент весьма умело и уместно. Нет, это не очередная эксцентричная политическая провокация. Была создана версия выступления лидера партии на диалекте харьянви.

В итоге, изначально англоязычное видео с помощью технологии липсинка стало доступным для понимания людям, которые говорят на этом диалекте и английского не знают.

Некоторые с помощью этой технологии предпринимают попытки обратить внимание общественности на волнующие их проблемы.

Бил Постерс выкладывает в социальные медиа дипфейки с Кардашьян, Марком Фрименом и Цукербером. Одна из его нашумевших работ — тизер для вымышленного тв-проекта с главой Amazon — Джефом Безосом.

Таким образом он пытается привлечь внимание к горящим лесам Амазонки. В том числе и внимание самого Безоса, который «одолжил название лесов для своей компании, чтобы стать самым богатым человеком на Земле».

Существуют примеры применения дипфейков и в рекламной сфере. Дэвид Бекхэм снялся в социальном ролике об опасностях малярии. Те же технологии помогли ему заговорить на 9 разных языках: носители произносили текст, а ИИ подстраивал его под артикуляцию футболиста.

Британская компания, снявшая рекламу, предпочитает называть это видео «синтезом», а не «дипфейком», чтобы избежать негативных коннотаций.

Также, вы скорее всего видели недавнюю рекламу Сбера с Жоржем Милославским. Эта очень качественная работа была сделана нашими соотечественниками из Челябинска. И сразу же привлекла внимание общественности. Те же умельцы создали молодого Брюса Уиллиса для компании Мегафон.

По этому поводу Олег Агейчев, режиссер и креативный директор Видеостудии Mozga говорит:

«Хотя технология уже достаточно известна, пока тренда на использования её в рекламе нет. Сейчас дипфейки в массовом сознании — это информационное оружие. И поэтому для брендов использование этой технологии в коммуникации — огромный репутационный риск. Возможно, смелые революционные бренды позволят себе такой ход, но скорее всего в ближайшем будущем это будут единичные случаи».

Интересным образом технология deepfake использовалась в музейном пространстве. Например, в Музее Сальвадора Дали во Флориде в честь 115-летия великого художника была организована специальная выставка Dalí Lives («Дали жив»).

Как говорят сами кураторы проекта, на этом мероприятии «искусство встречает искусственный интеллект». Благодаря использованию сгенерированного искусственным интеллектом прототипа художника, Дали лично общался с посетителями музея, рассказывал им истории о своих картинах и жизни, и даже делал селфи, которые отправлял посетителям на почту.

Как дипфейки вредят человеку?

Чем больший потенциал возможностей новые технологии открывают для людей, тем чаще люди начинают использовать их для достижения не всегда законных корыстных целей.

Сейчас можно обучить нейросеть воспроизводить нужный текст голосом конкретного человека, затем использовать аналогичные методы, что и в случае с индийской партией. В результате Вы получите видео, как человек говорит то, что Вам нужно, даже не зная об этом.

Или же обойтись без вовсе без видео, одним только голосом. Реальные примеры показывают, что этого может быть вполне достаточно. В январе прошлого года менеджер банка получил, вроде бы, обычный телефонный звонок.

Человек на другом конце линии утверждал, что является директором крупной компании, с которой менеджер ранее уже общался. Как утверждается в судебных документах, голос звонившего был крайне убедителен.

Это, а также электронные письма от компании и её юриста, убедили менеджера филиала в том, что фирма находится в процессе крупной сделки на сумму 35 миллионов долларов.

Менеджер банка последовал указаниям звонившего и начал инициировать ряд крупных денежных переводов от компании на новые счета. К сожалению, всё это оказалось изощренной аферой.

И это уже не первый подобный случай. В 2019 году похожая участь постигла энергетическую компанию в Великобритании: мошенникам удалось похитить около $243 000, выдав себя за генерального директора компании. И вряд ли этот случай будет последним.

По мнению палаты представителей конгресса США, дипфейки становятся угрозой национальной безопасности страны. Законодатели взволнованы тем, как применение этой технологии может влиять на предвыборные кампании партий и политическую обстановку в стране.

Калифорния стала первым штатом, где на законадательном уровне запретили распространение дипфейков с кандидатами во время предвыборной гонки.

Часто обычному пользователю сложно отличить смонтированное видео от настоящего. А по мнению экспертов, скоро технологии достигнут такого уровня, что видео уже будет невозможно отличить от оригинала.

Распространение ложной информации, вторжение в частную жизнь, разрушение репутации и — и это далеко не все, к чему могут привести дипфейки. Китай пообещал уголовно наказывать за их использование без надлежащей маркировки.

IT-гиганты – Facebook*, Microsoft и Google — пытаются этому помешать. Корпорации создают собственные датасеты, на которых разработчики смогут тренировать алгоритмы, обнаруживающие дипфейки.

Дипфейки также могут стать опасным инструментом в руках мошенников. Например, недавно злоумышленники запустили рекламу мастер-класса «по успешному использованию нейросетей и блокчейн-технологий».

На видео проект презентует Дмитрий Мацкевич, а всё это якобы разработано командой Dbrain. Только вот ни Dbrain, ни сам Дмитрий к этому проекту, предлагающему быстрые серьезные доходы с минимальным вложениями, отношения не имеют.

Просто благодаря магии дипфейков, другой человек, но уже от лица Дмитрия и рекламировал проект и приглашал людей на мастер-класс.

Или, например, случай летом 2019 года, когда мошенники использовали фейковое видео с Дмитрием Нагиевым. На записи он предлагал принять участие в розыгрыше ценного приза.

Переходя по ссылке, пользователи оказывались на фишинговой страницу и, как правило, теряли деньги. Ну и многие, конечно, видели совсем недавно дипфейк с Олегом Тиньковым, созданный все также для мошеннических целей.

Елена Коршак, продакт-директор WaveMaker придерживается мнения, что:

«Едва ли возможно запретить использование DeepfakeAI, так же, как и удалить весь пользовательский фейк-контент. Но важной задачей ближайших лет в нашей стране станет принятие законов, которые на государственном уровне будут регулировать «зону свободы» применения технологии. А мы станем серьезнее относиться к источникам информации».

Обратная сторона медали

Дипфейки – это инструмент. И его помощью создается иллюзия реальности того, что на самом деле нереально. Это делается и в благих целях, и ради развлечения. А также для дезинформации и мошенничества.

И вроде бы нам всем понятно, что в скором будущем мы обязательно столкнемся с огромным количеством лжи, выдаваемой таким образом за правду. И конечно мы все будем бдительны, и будем тщательно выбирать, чему верить.

Ведь никто не хочет оказаться обманутым. Но, сейчас я расскажу историю, которая заставит Вас взглянуть на проблему распространения дипфейк-контента с другой стороны.

Итак, 17-летняя школьница из Пенсильвании, Мэди Хайм, получает с анонимного телефонного номера сообщение. В нем оказывается видео, на котором она, то есть Мэди, занимается непристойными вещами.

Нет, это не очередной порно-контент. На видео девушка пьет и курит. Казалось бы, ну, бывает. Но девушка заявляет, что она в шоке, и ничего подобного никогда не делала. С неизвестного номера продолжают поступать сообщения с угрозами распространить это видео.

Девушка рассказывает матери, и они обращаются в полицию. Тогда выясняется, что подобные сообщения получают еще две школьницы, подруги Мэди из команды поддержки.

И также утверждают, что видео поддельные. После чего полицейские отслеживают IP-адрес, с которого были отправлены сообщения, и выходят на Рафаэллу Споун, являющуюся матерью еще одной девушки из той же школьной группы поддержки.

Оказывается, что девочки были в ссоре, на почве конкуренции за место в составе команды.

По мнению полиции, Рафаэлла Споун узнала об этом и решила скомпрометировать соперниц дочери, ведь по правилам им запрещено курение и употребление алкоголя. Женщина рассылает поддельное видео самим девочкам, их тренерам и учителям, чтобы обидчиц ее дочери выгнали из команды.

Мотив очевиден, дело раскрыто. Женщину арестовывают. Ей предъявляют обвинения в преследовании, создании поддельных видео и отправке оскорбительных сообщений. СМИ расписывают историю во всех красках и все новых подробностях.

Окружной прокурор округа Бакс, Мэтт Вейнтрауб на пресс-конференции заявляет о том, что видео поддельные и созданы с помощью технологии дипфейк. Также он, отвечая на вопросы журналистов, утверждает, что теперь подобное доступно каждому желающему, нужно лишь скачать приложение и загрузить пару фотографий.

Ну и что, вроде бы обычная история про фейковое видео, созданное с целью опорочить и подмочить репутацию. Интересно становится дальше, когда появляются мнения, что видео с девочками – настоящие.

И говорят об этом не журналисты и полицейские, а профессионалы в создании дипфейков.

Крис Уме, сделавший того самого Тома Круза из Тик-Тока, считает, что видео реальное. Или, например, создатель дипфейка Путина из Поперечного, Сергей, аналогично заявляет, что на записи нет никаких признаков подделки.

Что же получается, мы имеем дело с технологией совершенно иного уровня, неизвестной профессионалам, но почему-то доступной для женщины средних лет из Пенсильвании?

Звучит невероятно. Шерлок Холмс советовал отбросить все невозможное, и то, что останется, считать правдой.

В нашем случае правдой оказывается то, что девочкам удалось убедить полицию, журналистов и власти штата, что видео с ними – поддельные, хотя на самом деле, они реальны.

И дело тут вовсе не в том, что трое школьниц нарушили правила поведения сборной по чирлидингу. А в том, что мы имеем, возможно, первый в истории прецедент, когда реальность была выдана за дипфейк. А не наоборот, как мы уже привыкли.

Вдумайтесь, ведь всю свою жизнь мы все считали видеозаписи прямым доказательством, что снятое реально. Речь не о фантастических фильмах, само собой.

Вот, например, сняли Вы на видео своего пьяного соседа, который, проникшись духом вандализма, украшает стены подъезда изображениями фаллических символов. И вы уверены, что, предъявив эту видеозапись ЖКХ полиции, да и самому соседу, Вы будете иметь неоспоримое доказательство истинности вашей версии случившегося.

Но вот на утро сосед заявляет: «Это не я, это все дипфейк». И, как мы успели убедиться на примере с американскими школьницами и их родителями, доказать свою правоту может быть совсем не просто. А значит, что в будущем мы столкнемся не только с массой подделок, искажающих представление о реальности, но и с попытками аннулировать весомость доказательств, снятых на видео, свалив все на работу нейросетей.

Следовательно, обществу позарез нужно научиться выявлять дипфейки. Есть ли шансы этого достичь? Давайте разберемся.

Как распознать дипфейк

Обычно, мошеннические видео можно распознать, не прилагая сверхчеловеческий усилий. Как в случае с «поддельным» Тиньковым - человека в ролике, при внимательном изучении, не трудно отличить от реального, голос другой, качество видео ужасное, да и распространяется оно в соцсетях - то есть заведомо предназначается для просмотра с небольших экранов мобильных устройств.

Это как раз то, на что и рассчитывают мошенники. В лентах соцсетей многие пользователи поверят даже просто внешне похожему персонажу с символикой известного банка рядом.

Эксперты советуют обратить внимание на пять основных моментов, встречающихся в фейковых видео:

- Излишняя пикселизация, дефектное, нечеткое и смазанное изображение

- Неестественная мимика, особенно при моргании, поворотах головы, движении бровей и губ

- На низкое качество видео, за которым нередко пытаются скрыть несовершенную работу нейронных сетей;

- На различия в фигуре, прическе и голосе. Мошенники нередко выбирают похожих внешне актеров, а голос может быть также сгенерирован с помощью технологии дипфейк, например, в программах RealTimeVoiceCLoning, Resemble и Descript;

- В наиболее популярных решениях заменяется только лицо, поэтому можно заметить границу замененного лица, различие в тенях, освещенности и оттенке кожи.

Это все применимо лишь к низкокачественным фейкам. Но есть и такие, где заметить разницу невооруженным глазом почти невозможно. Сейчас существуют разные автоматизированные системы, которые распознают дипфейк.

Одну из таких систем разработали в Университете Буффало, она определяет подделку по ошибочным отражениям в глазах.

Facebook совместно с Microsoft устроили конкурс с призовым фондом в $10 млн на лучшую программу-детектор фейковых видео. Всего в конкурсе участвовали 2114 разработчиков, которые создали около 35 тысяч моделей.

Оценка эффективности алгоритмов проводилась двумя способами. Первый – стандартный, в нем использовался заранее предоставленный разработчикам тестовый датасет. Второй – повышенной сложности.

В нем использовались видео с бегущими строками, фильтрами и актерами, которые частично прикрывали лицо. Согласно турнирной таблице на Kaggle, при оценке работы первым способом побетелем оказался пользователь под ником Good At Curve Fitting – точность при определении дипфейков с помощью его алгоритма составила 82,56%.

При использовании для проверки усложненного датасета победил белорусский разработчик Селим Сефербеков из компании Mapbox. Его алгоритм смог определить дипфейки с точностью 65,18%.

Подобные новости спешат нас обнадежить – еще чуть-чуть, и станет возможным установить программу, которая будет бить тревогу, если просматриваемый контент содержит результат деятельности генеративных сетей.

Что-то наподобие антивируса, только для дипфейков. Но есть и плохая новость. Она заключается в том, что между создателями алгоритмов для генерации дипфейков, и разработчиками программ по их обнаружению идет своеобразная гонка вооружений.

Когда обнаруживается несовершенство дипфейка, на его основе создают способ обнаружения, но следующее поколение алгоритмов для генерации уже учится обходить этот способ.

«Когда технологичная компания тратит миллионы на борьбу с конкретной технологией, это говорит только об одном: сама технология вынуждена будет развиваться и становится лучше, чтобы обойти самые современные способы защиты. Так что все самое интересное впереди» - считает Олег Бутковский, креативный директор UNDRAFTED

Подводя итоги

Дипфейки — это не добро, но и не зло. Это всего лишь инструмент. С его помощью можно сделать смешной видеомем или донести важную информацию конкретной группе людей. Но в то же время можно нанести кому-то вред.

В итоге всё, как и всегда, зависит исключительно от того, к кому в руки этот инструмент попадёт. К сожалению, контролировать и регулировать распространение и использование подобных программ очень сложно.

Михаил Перловский, креативный директор Anybodyhome!, считает, что: «Эта технология, как и многие другие, интересна не своей механикой, процессом натаскивания скриптов на картинки, и не самой возможностью поменять лицо на видео. Интересна она тем, что технологии всё чаще апеллируют уже не столько к моральному выбору человечества, сколько к личному понятию нормы»

Мир меняется, и нам следует меняться вместе с ним. Стоит быть готовыми к тому, что технологии продолжат менять нашу жизнь и к лучшему, и к худшему одновременно, как они это всегда и делали.

Новшества не только механически изменят привычную нам реальность, но и затронут ряд этических вопросов, ответы на которые каждому надо будет найти самостоятельно.

Насчет будущего применения этой технологии существует множество версий, напишите в комментарии, что Вы думаете по этому поводу.

Ну а мы, конечно же, будем надеяться, что дипфейки в полной мере раскроют свой созидательный потенциал, и не будут использоваться со злым умыслом.

А чтобы быть в курсе последних событий не только в мире фальшивых лиц, но и технологий в целом – подпишись на канал, поставь лайк и нажми на колокольчик.

Заглядывай на сайт и в наш телеграм-канал – там ещё много интересного.

И, конечно, заходи к нам на вечеринку посмотреть очередную презентацию от Apple в крутой питерский бар.

Будет интересно!